30 激活函数

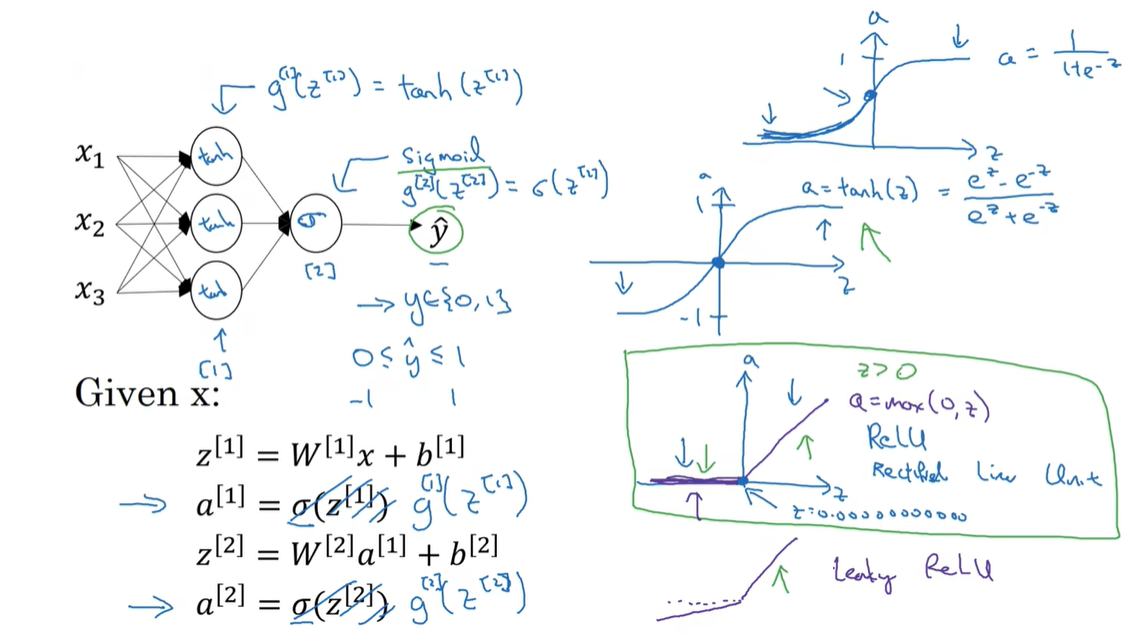

30.1 Activation functions

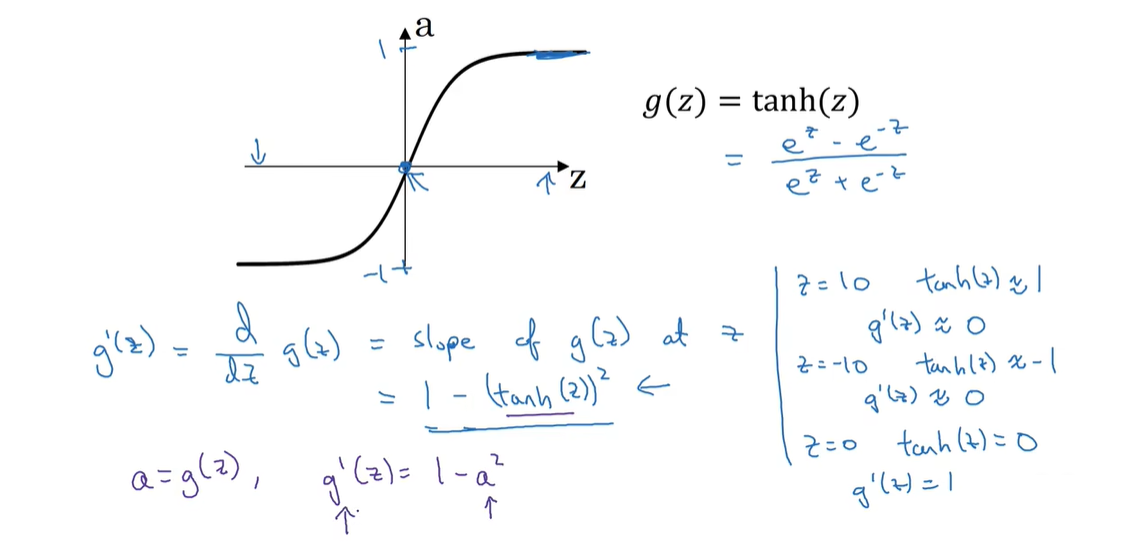

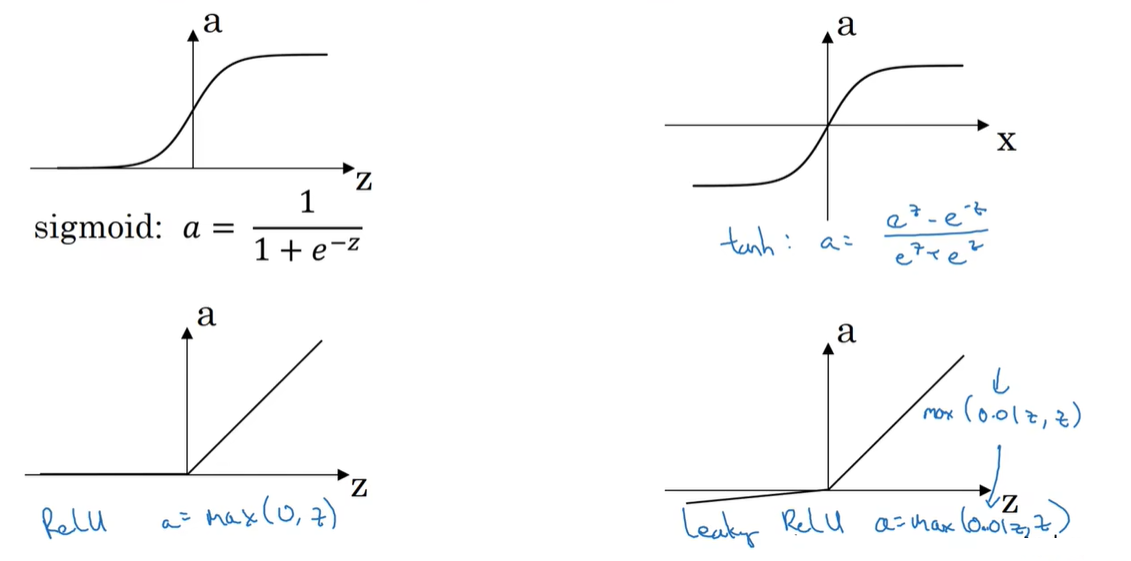

sigmoid函数总是表现要比 tanh双曲正切函数要好一点,这是因为它的值域在 [-1, 1] 之间,激活函数的平均值是 0, 你可能需要平移所有数据,让数据平均值为 0, 使用 tanh 而不是 sigmoid 也有类似于庶几乎中心化的效果

它们均有的缺点是,当向两边无限延申的时候,他俩的斜率都非常地小,这会拖慢梯度下降法。

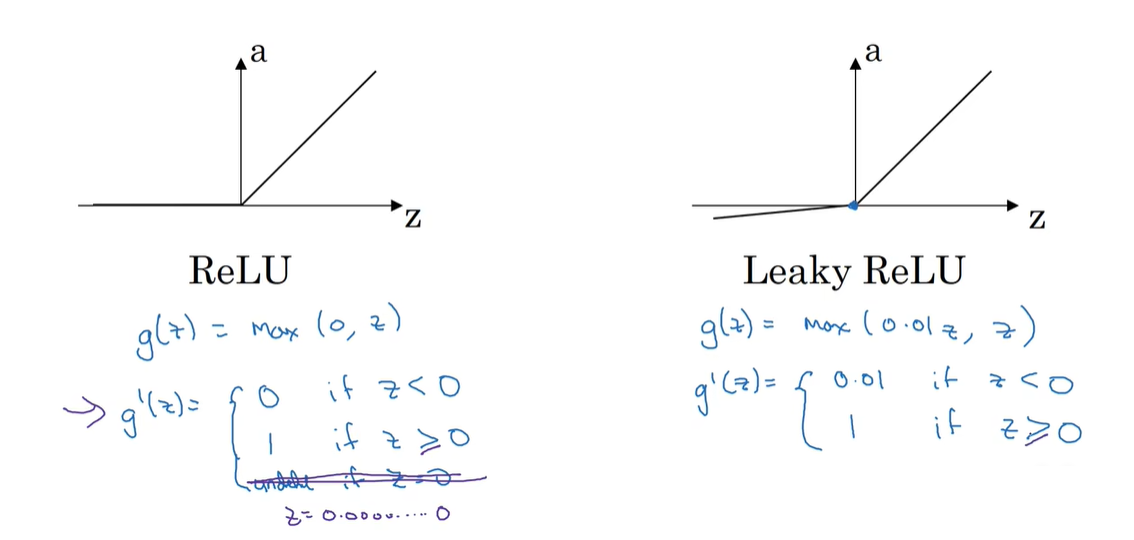

经验法则:当你二分类地时候,最好使用 sigmoid 函数,其他默认选择 ReLU 或者 leakyReLU

30.2 Pros and cons of activation functions

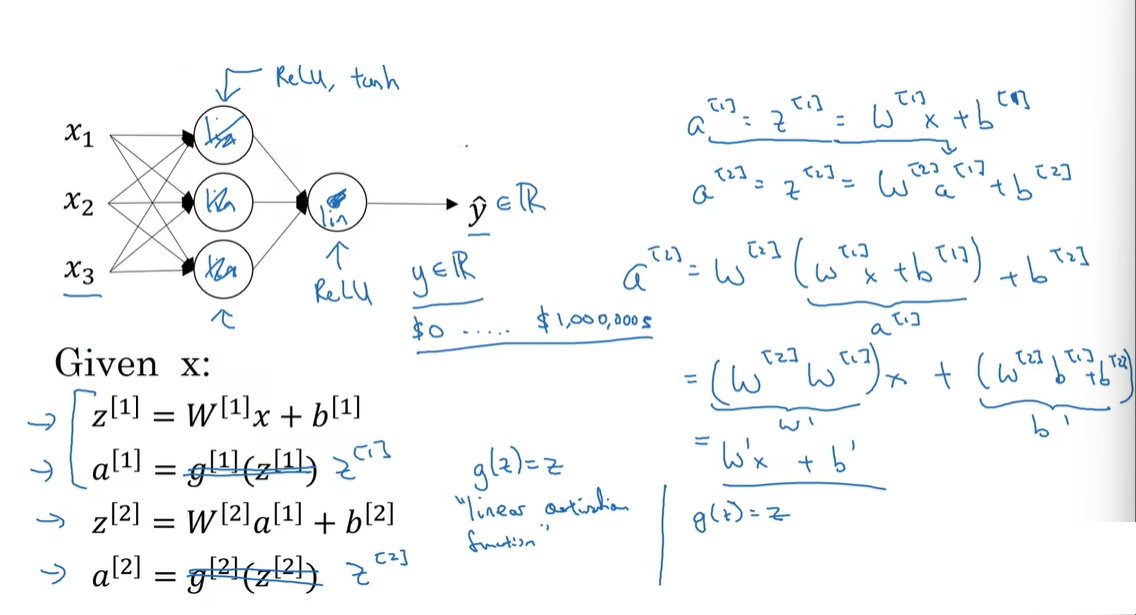

30.3 Why use activation function?

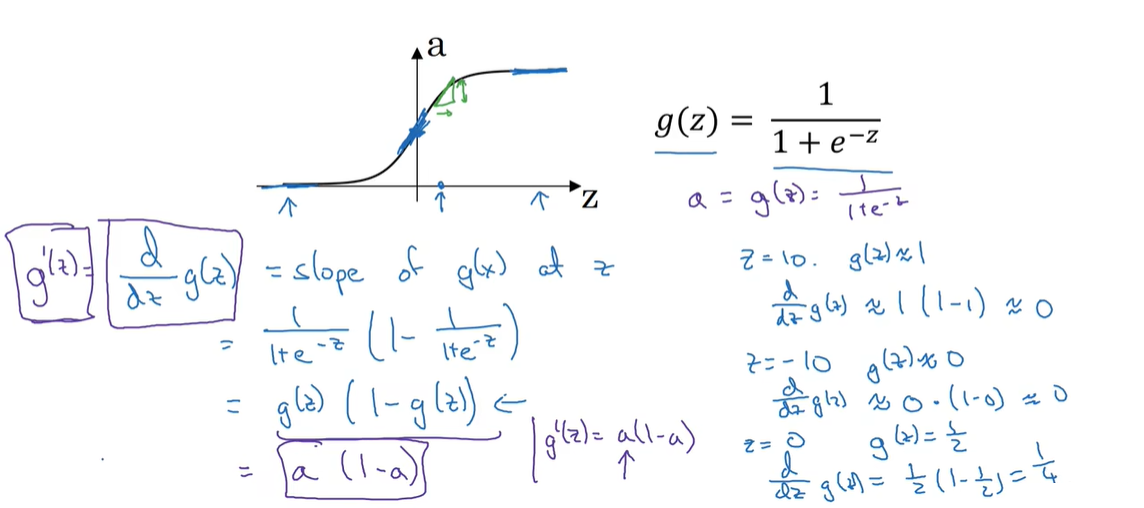

30.4 Sigmoid activation function