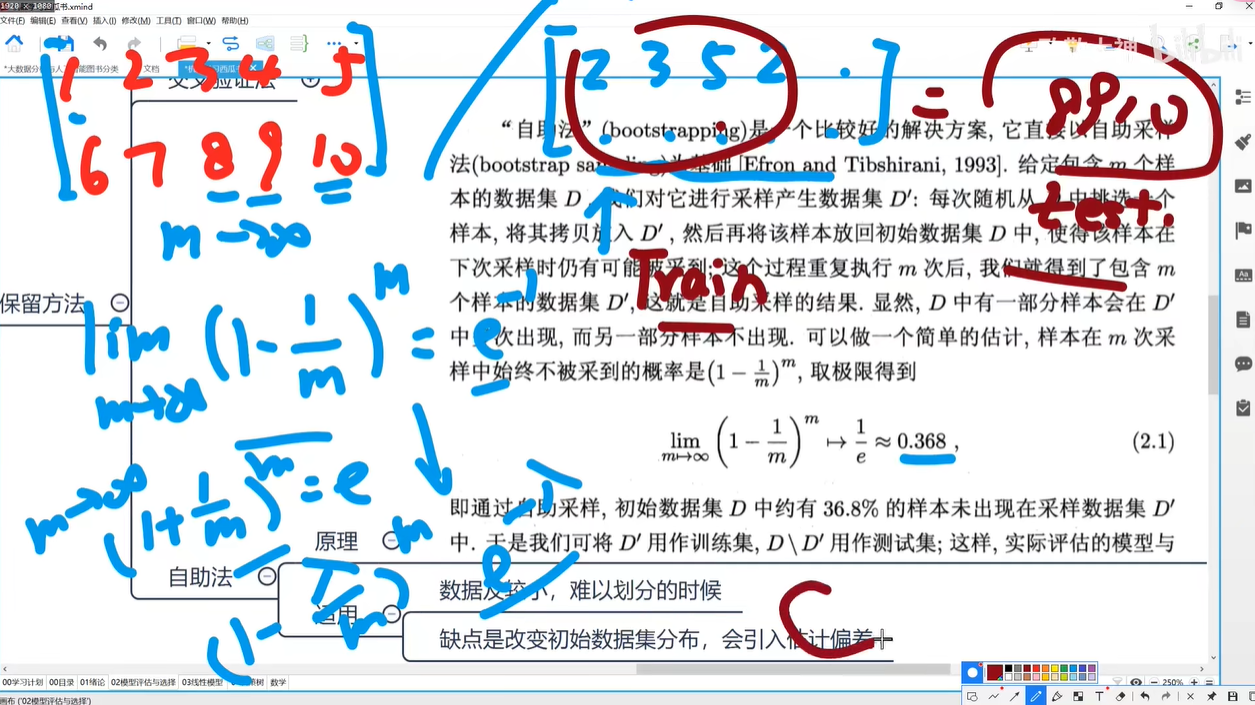

0204 K折交叉验证

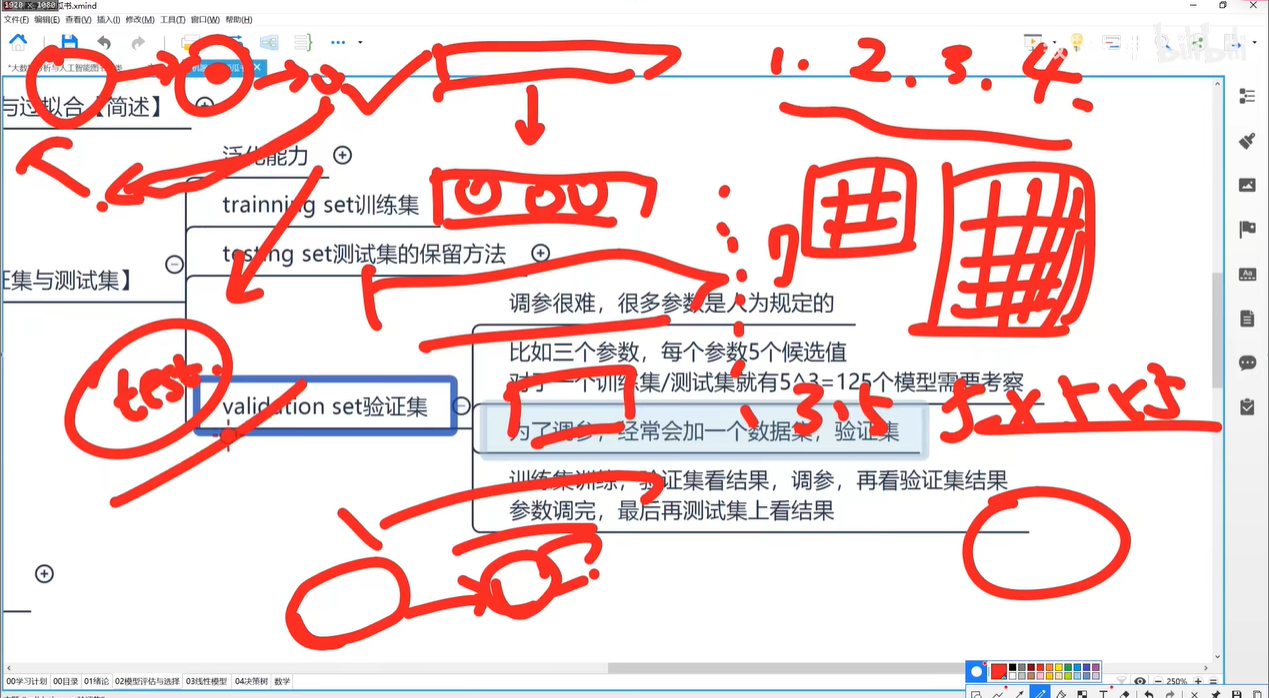

0205 测试集分割留出法

0206 验证集

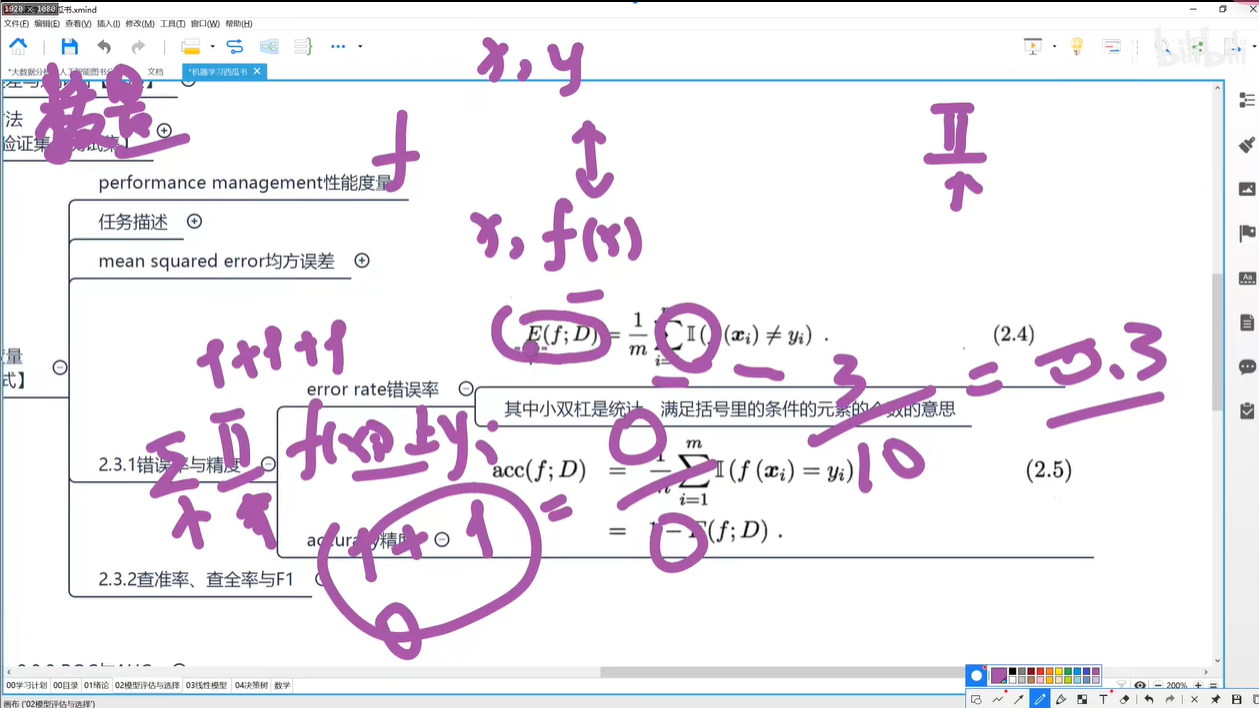

0207 均方误差

0208错误率与精确度公式

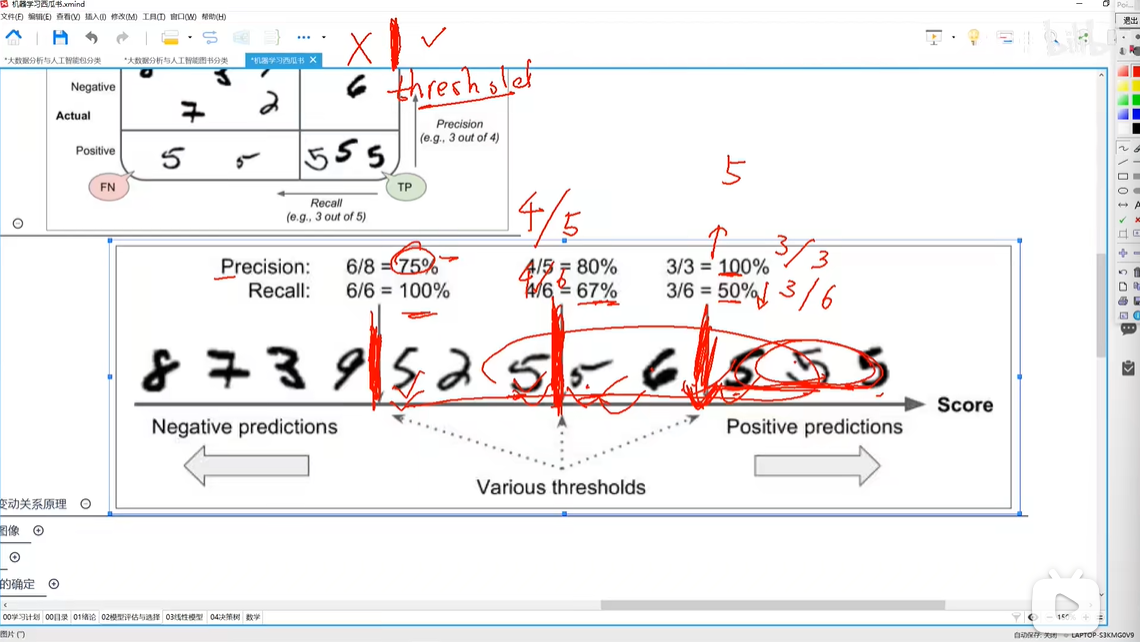

0209查准率与查全率

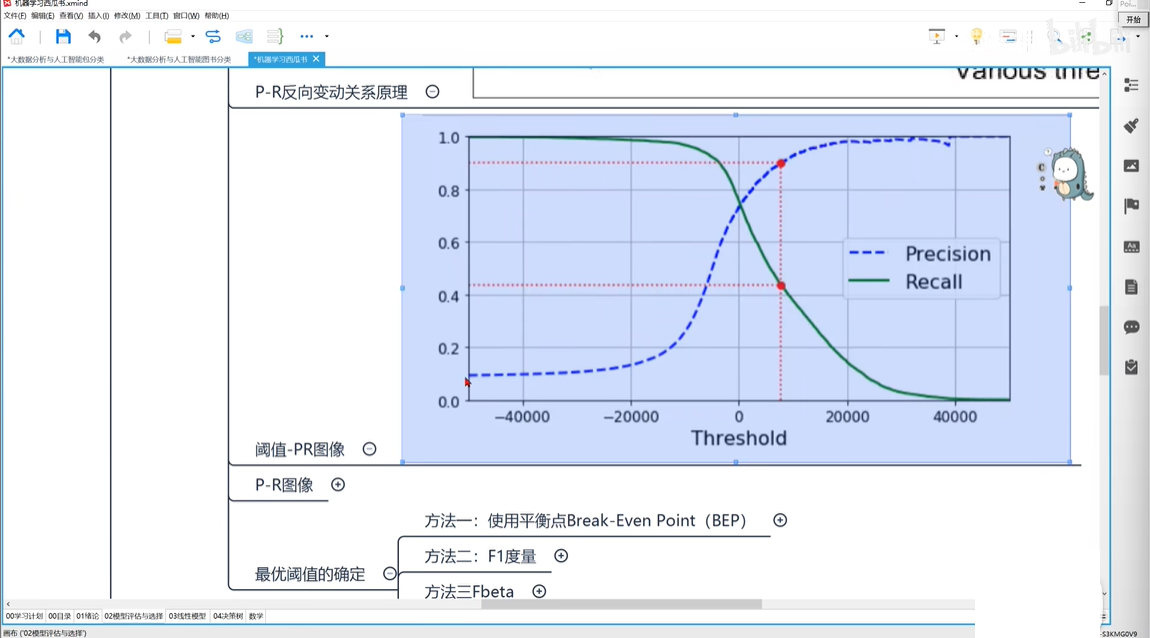

0210P-R反向关系原理

0211 P-R反向关系图

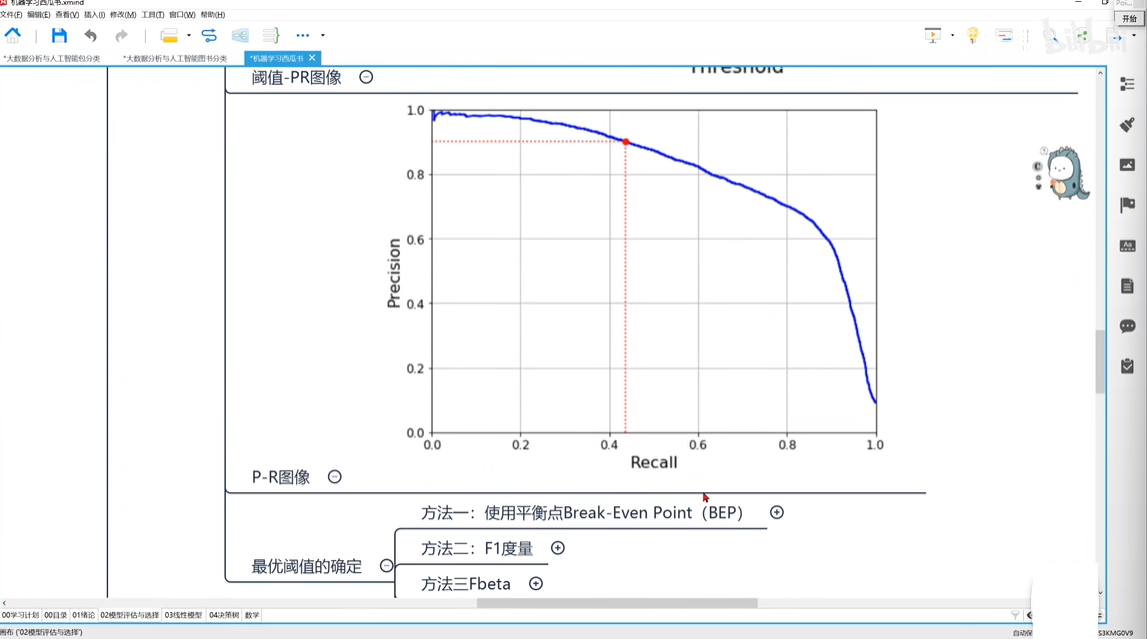

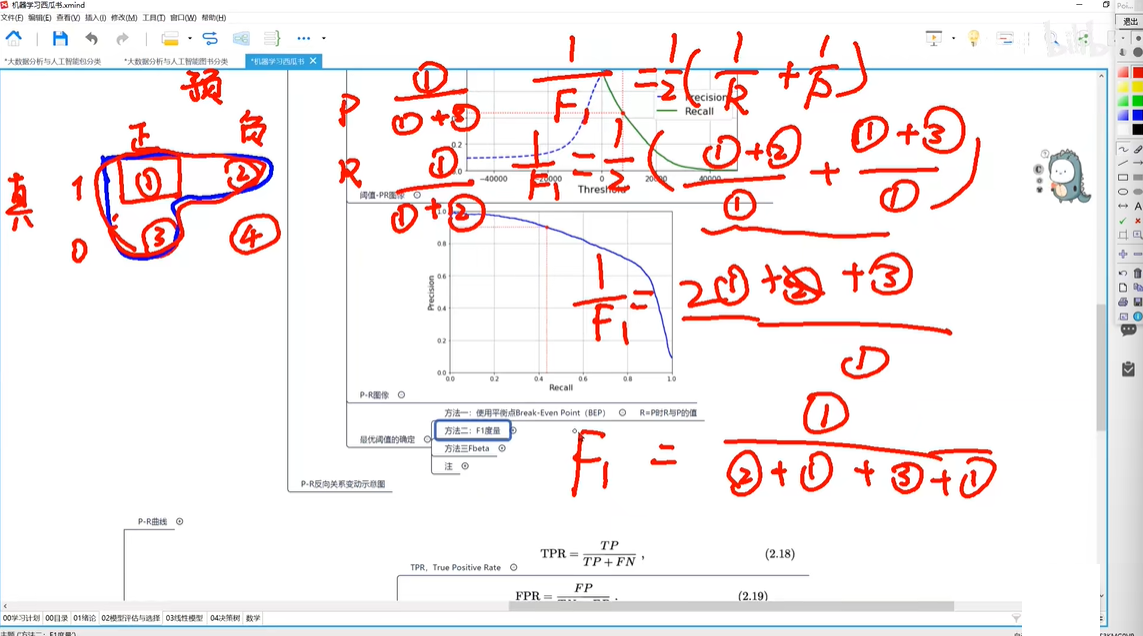

0212 P-R加权调和平均数

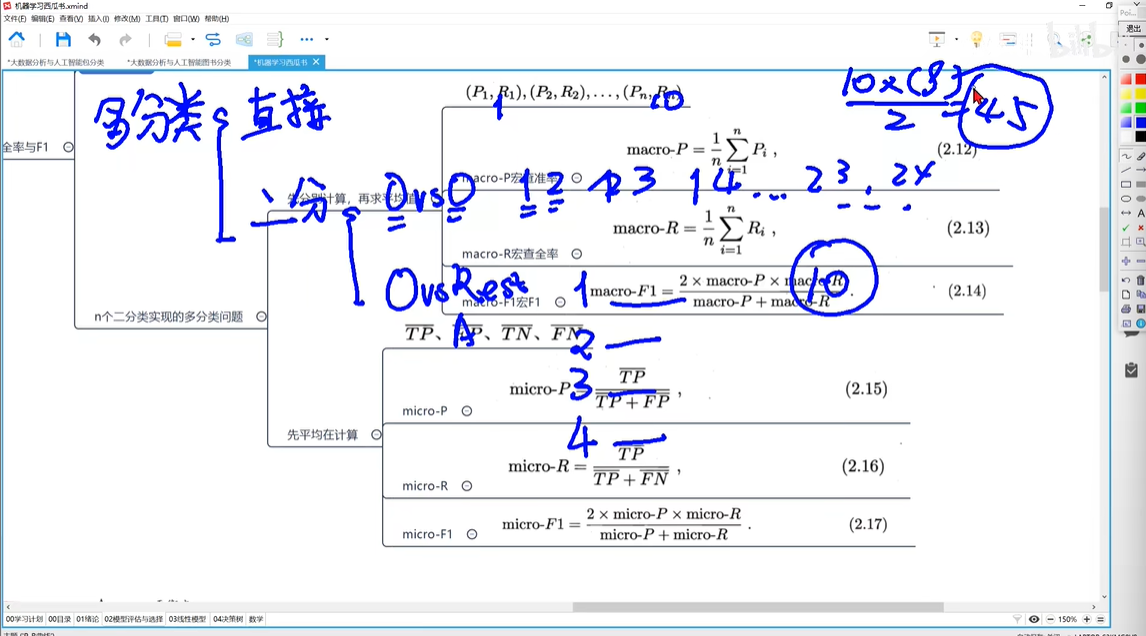

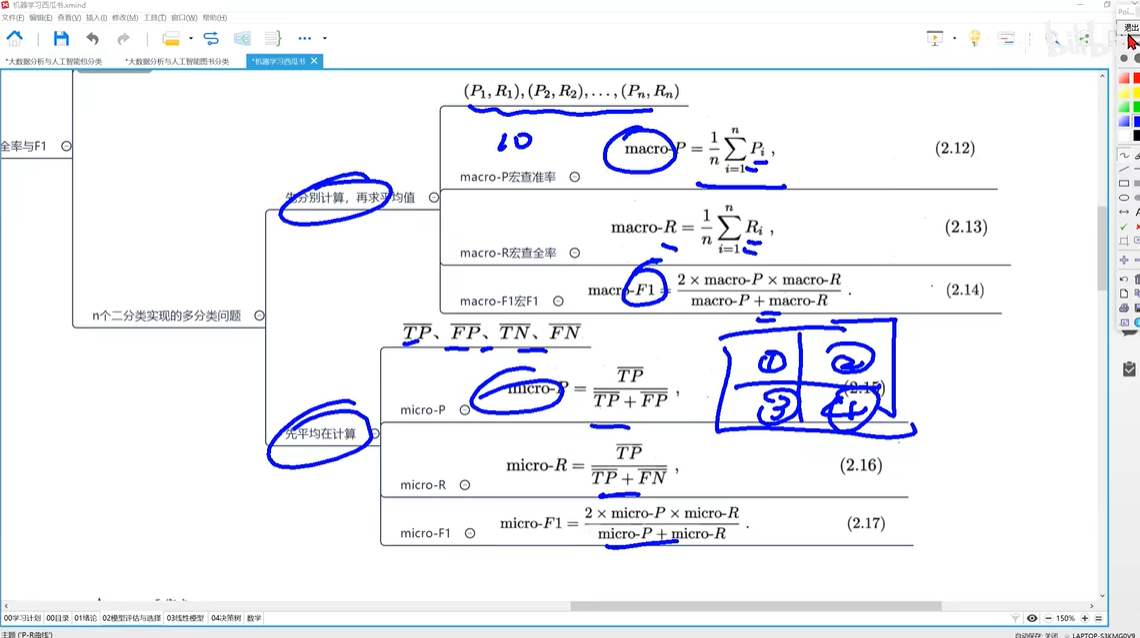

0213 macro_microP-R

0214 使用P-R曲线比较不同模型

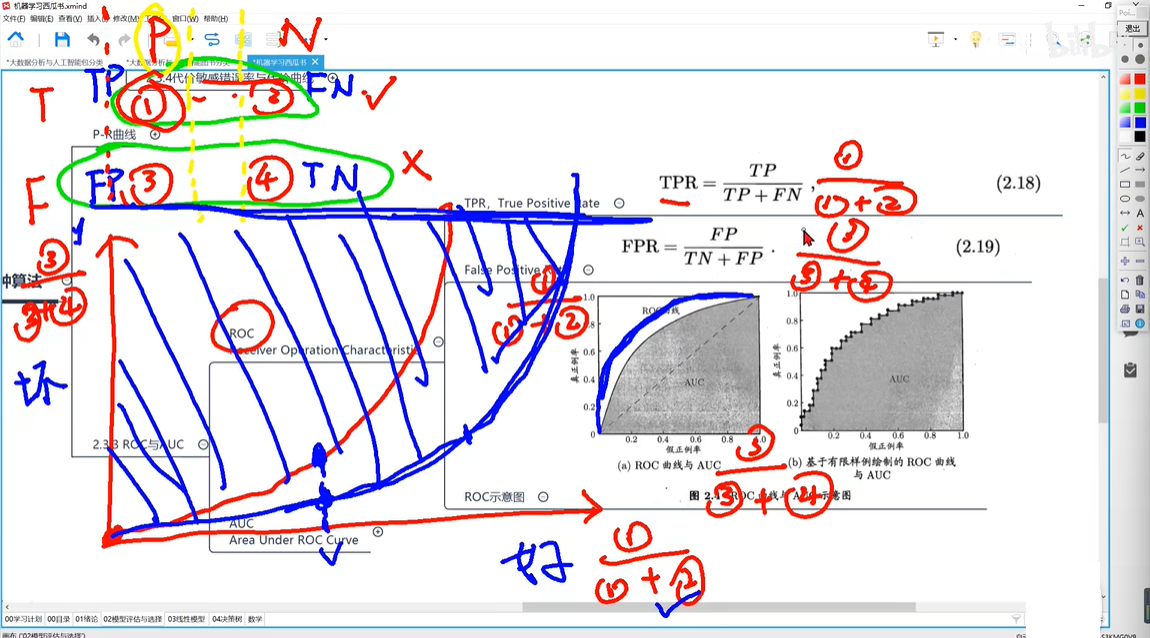

0215 ROC曲线

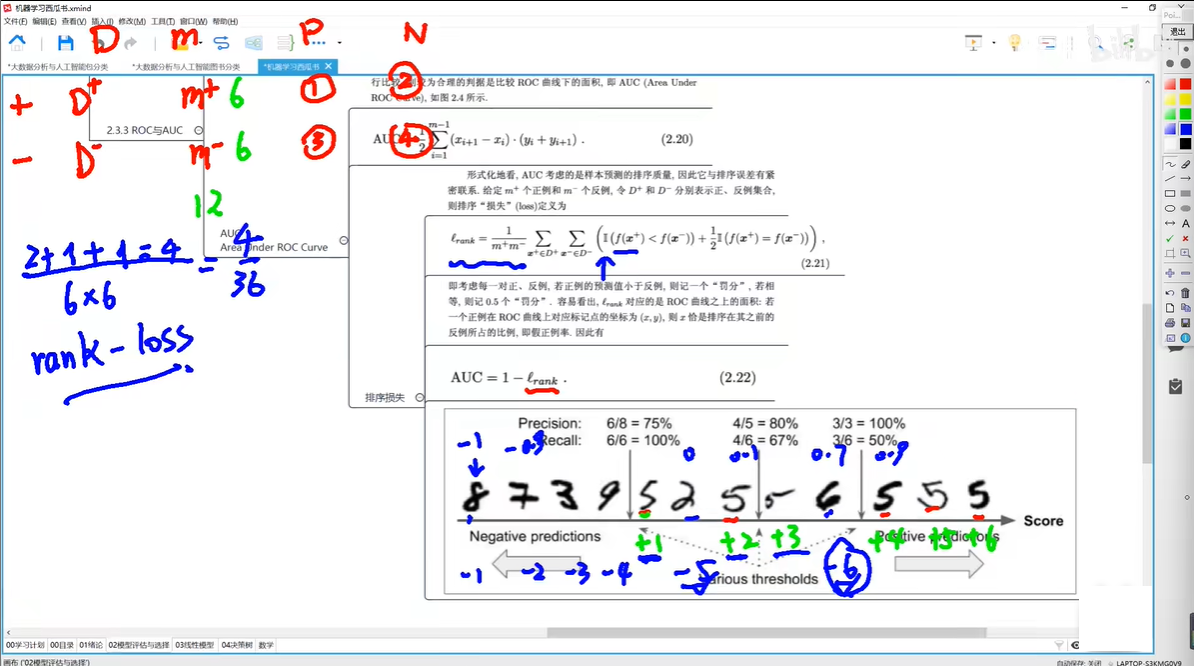

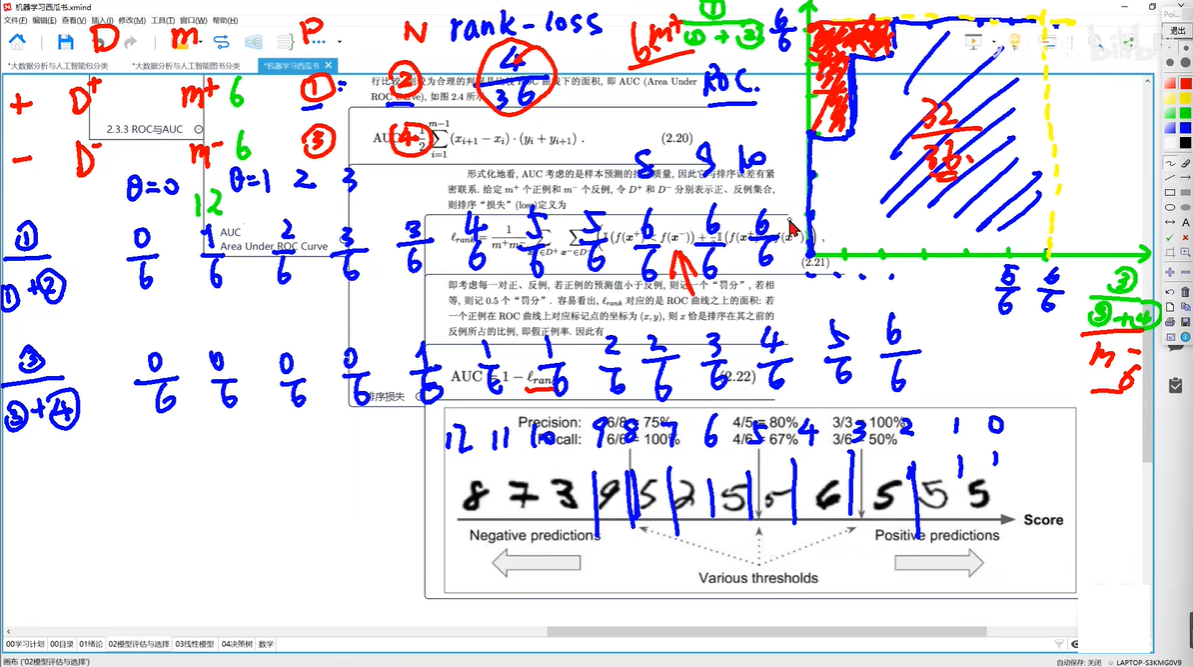

0216 排序损失rank-loss

0217 AUC与rank-loss

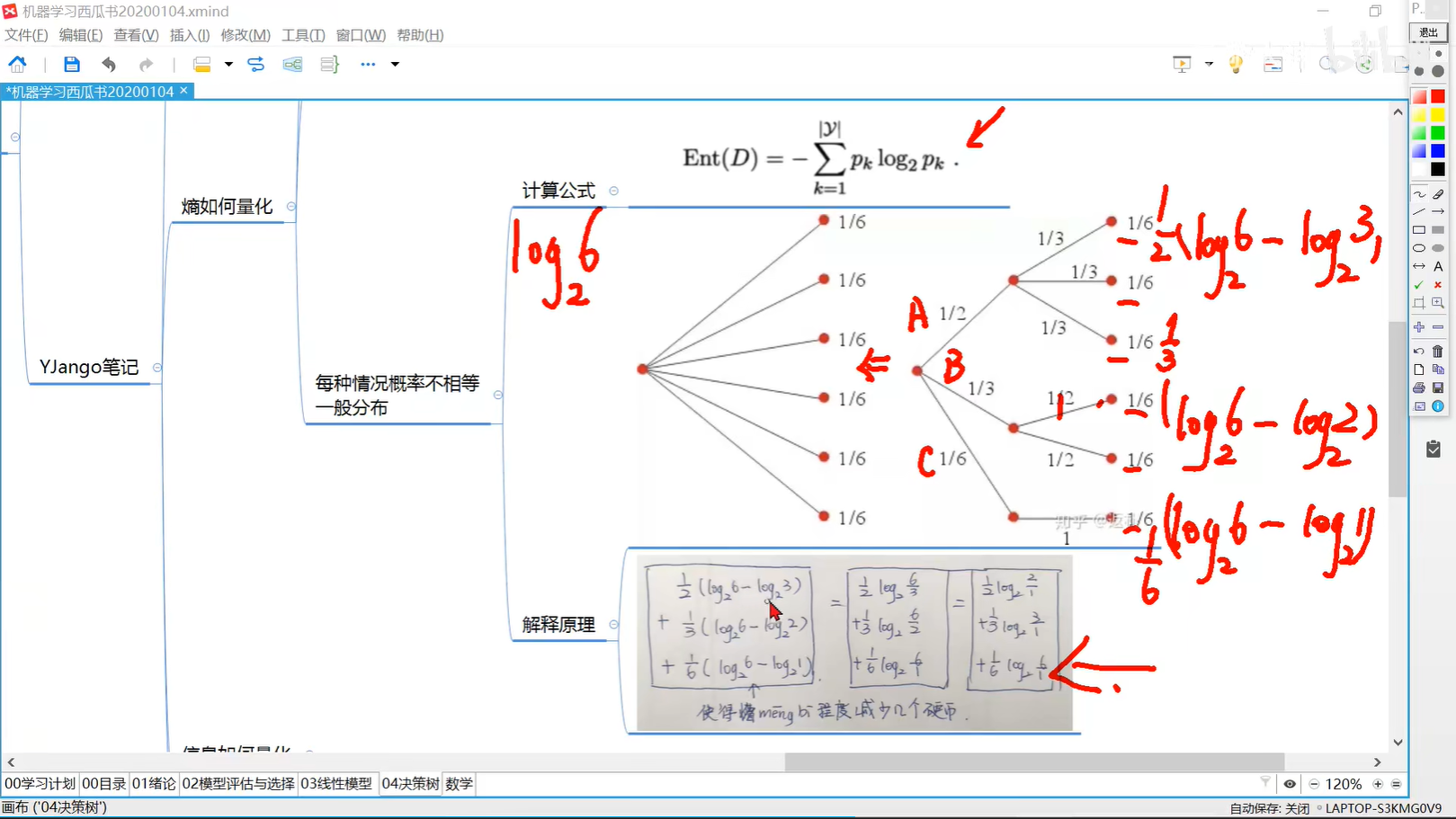

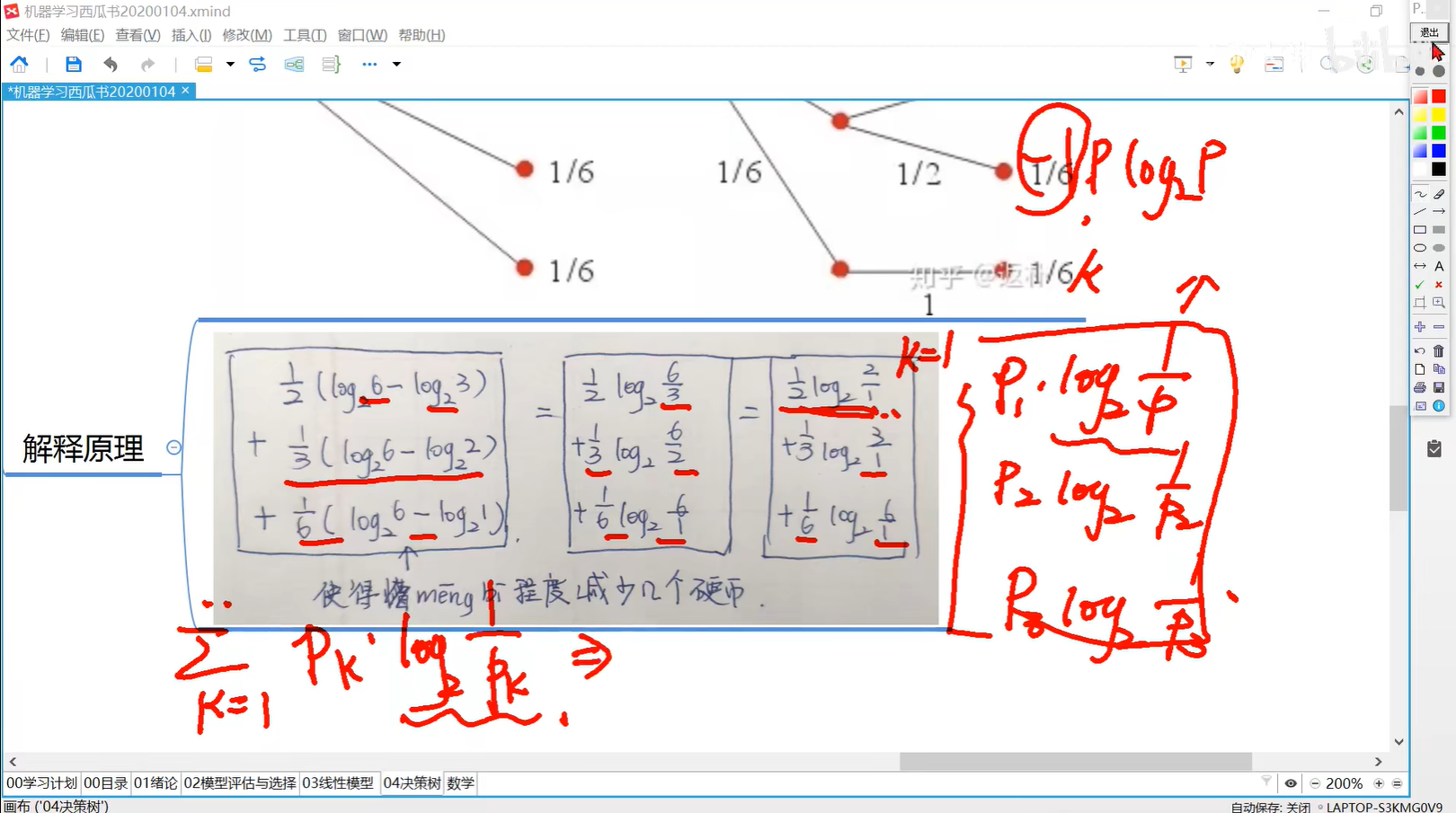

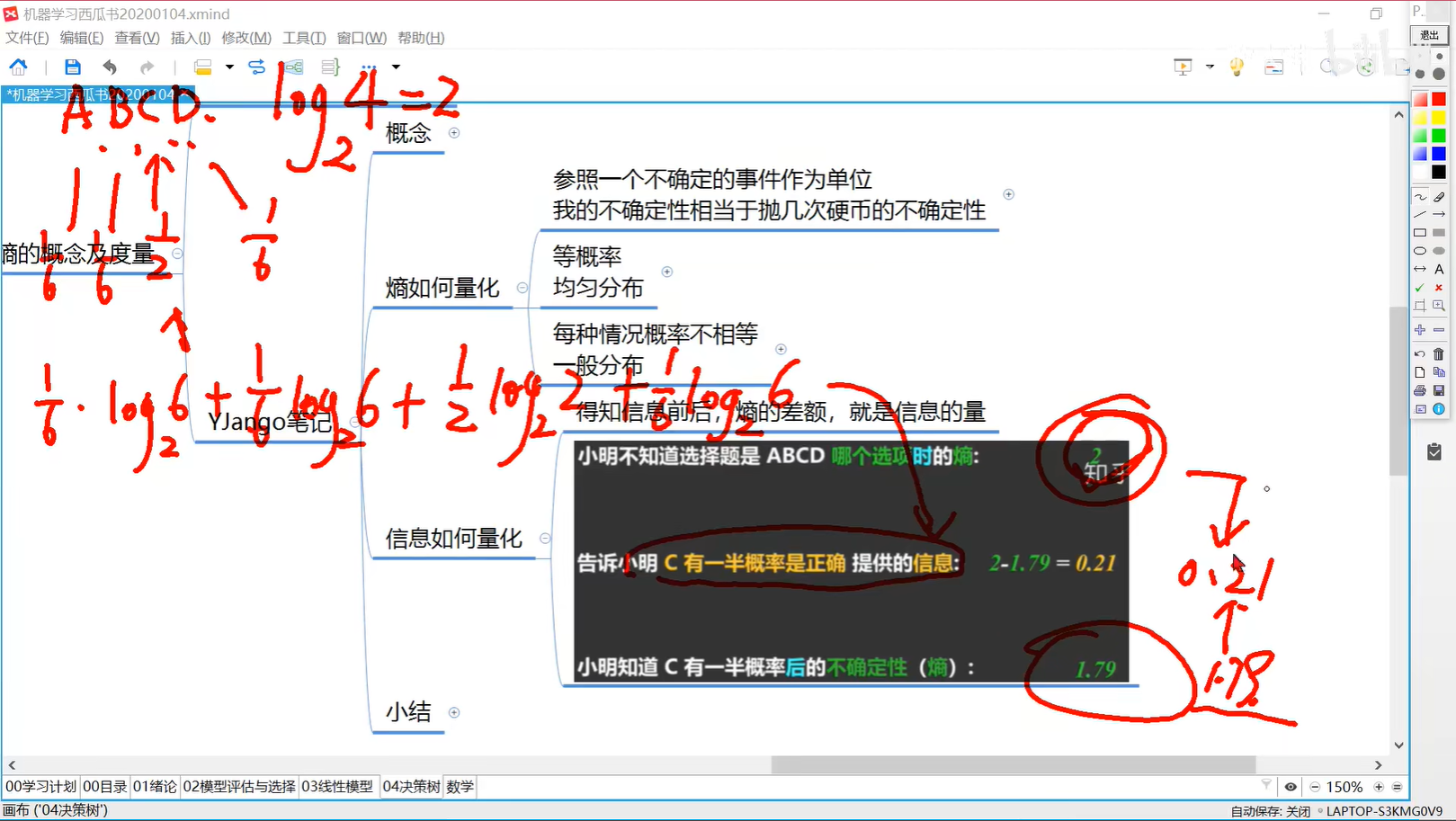

0403 熵的度量:一般分布

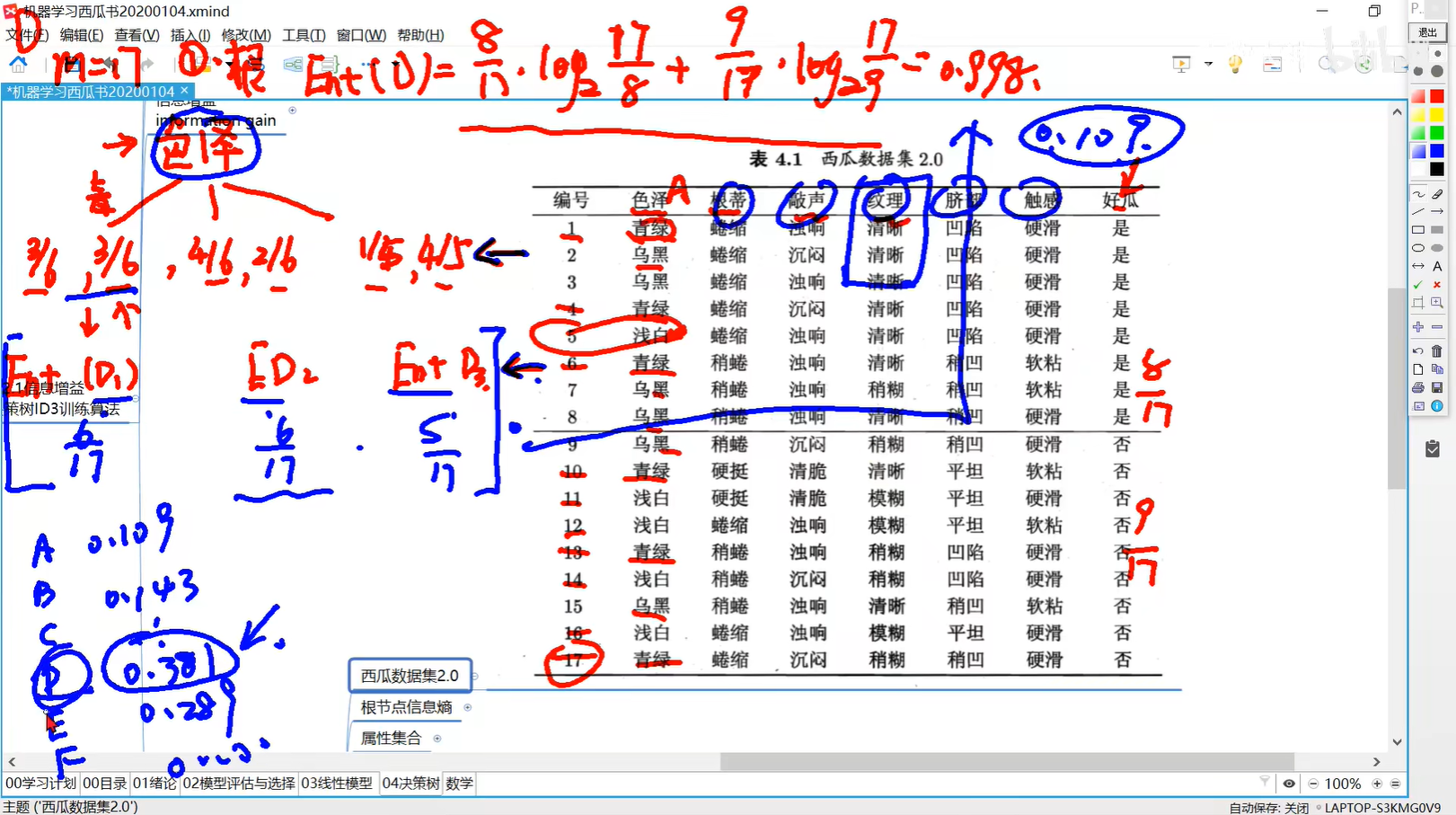

0404 信息的度量:信息增益

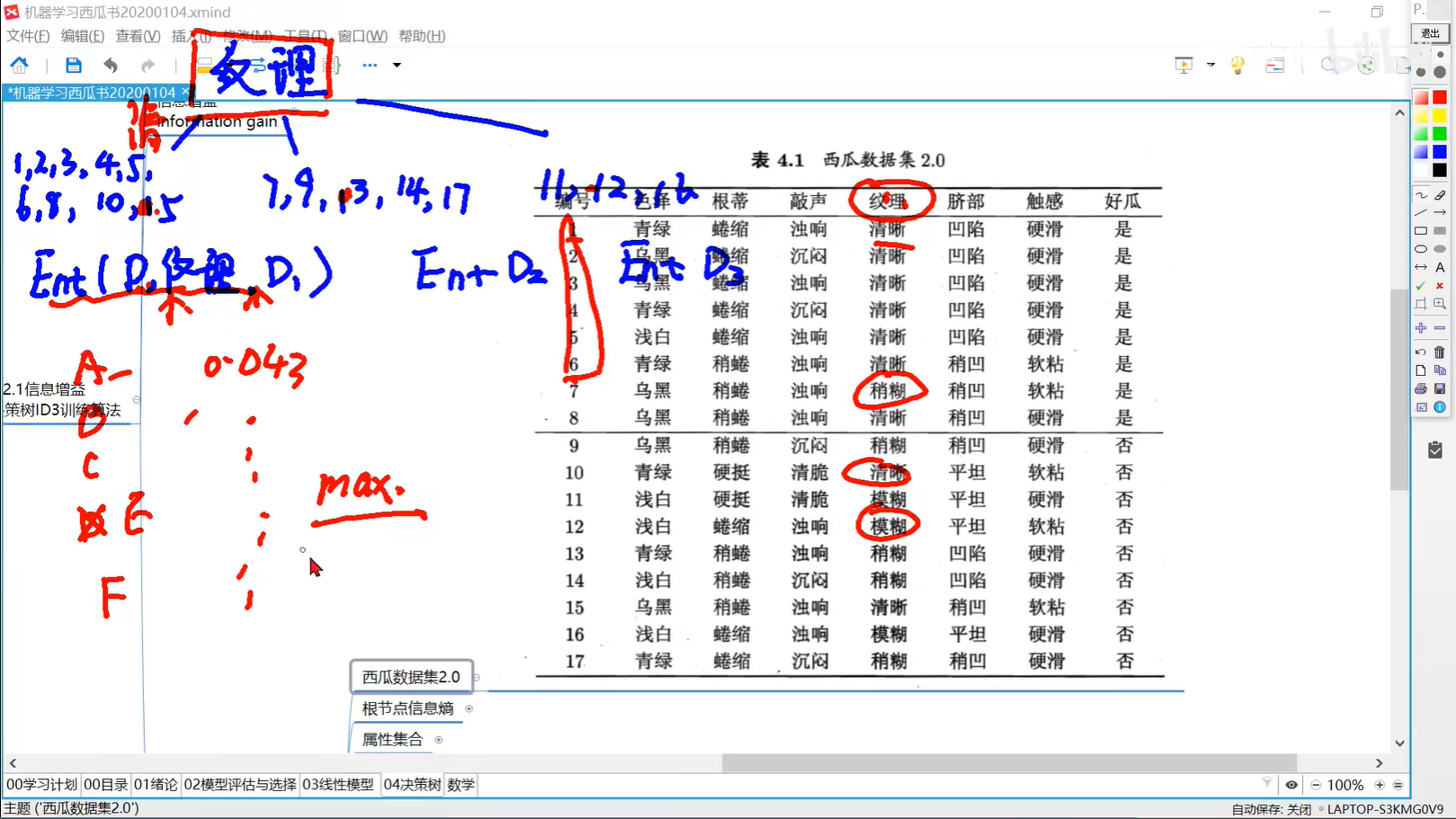

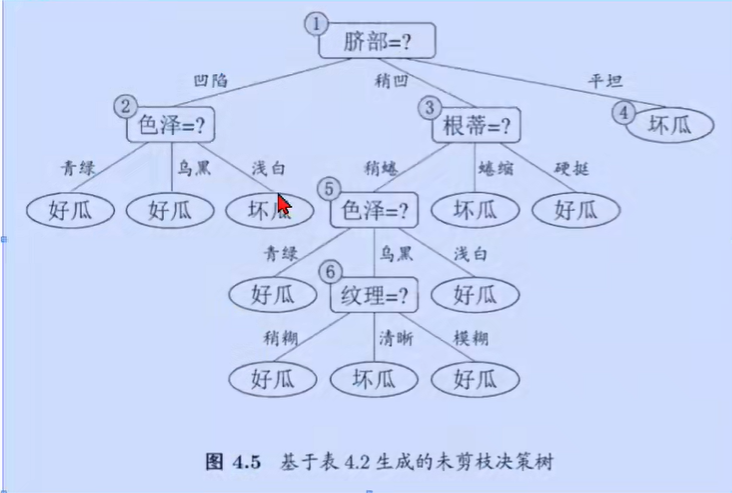

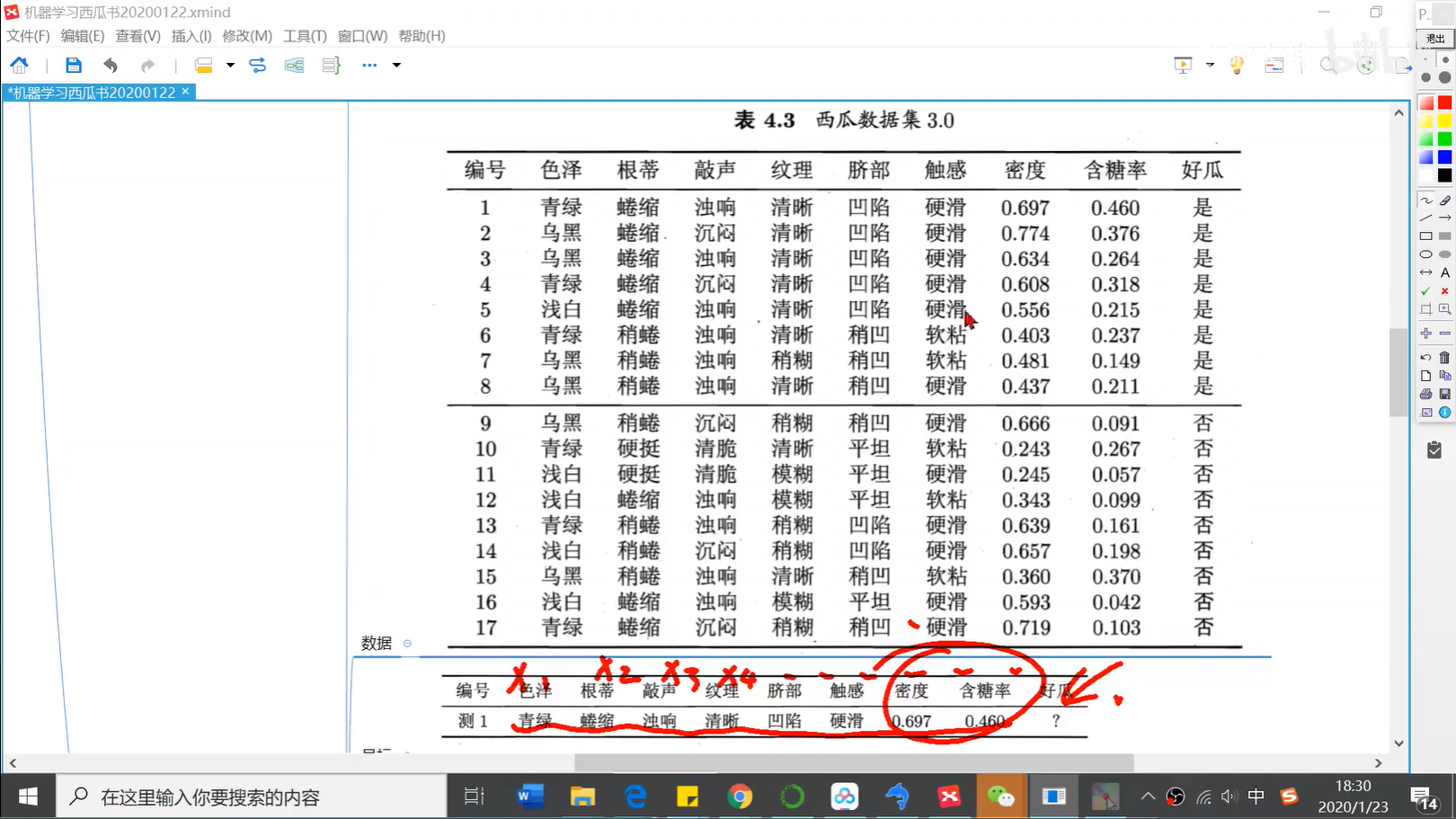

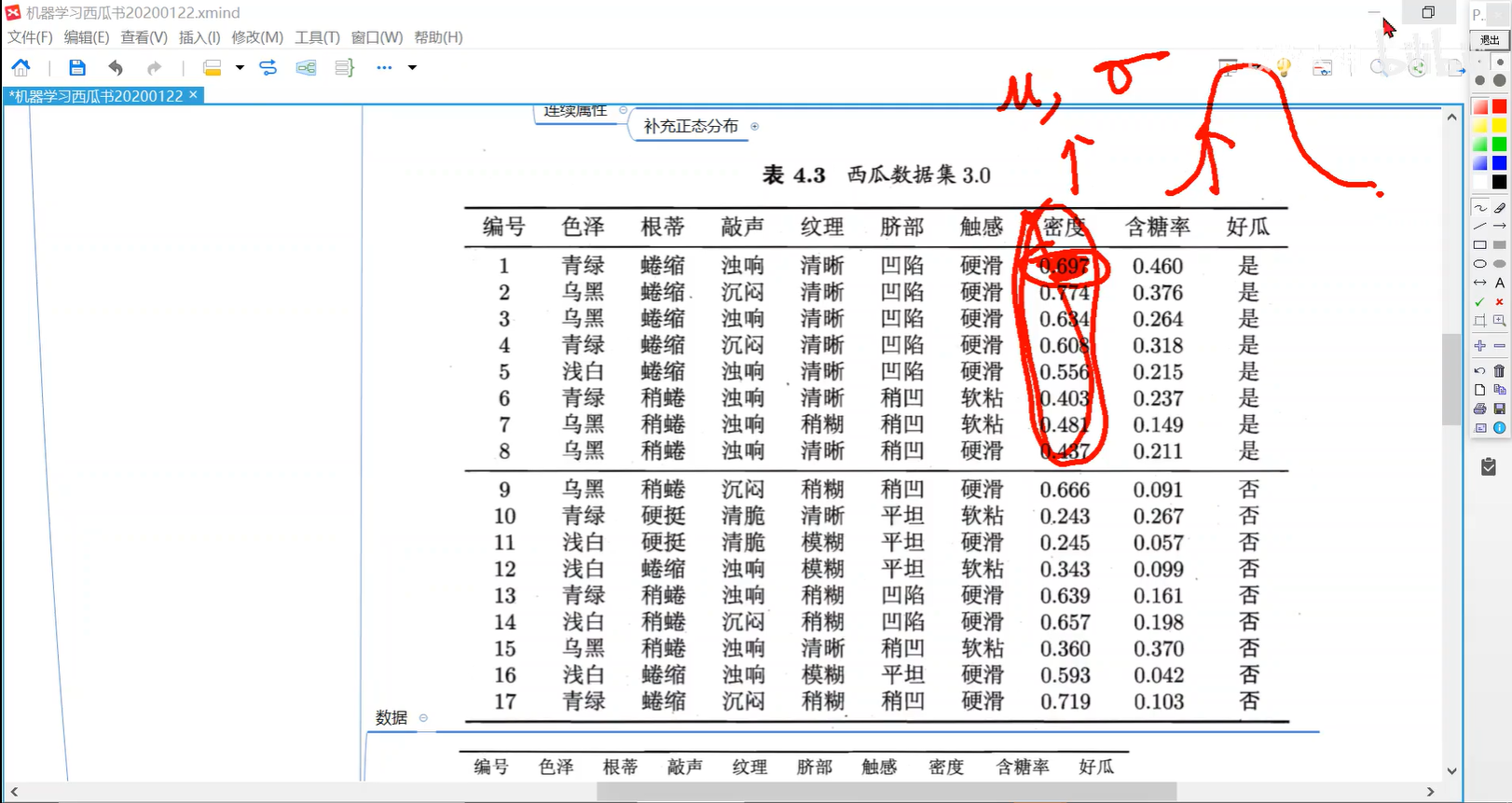

0405 决策树ID3算法举例:好坏西瓜

0406 好坏西瓜继续分叉

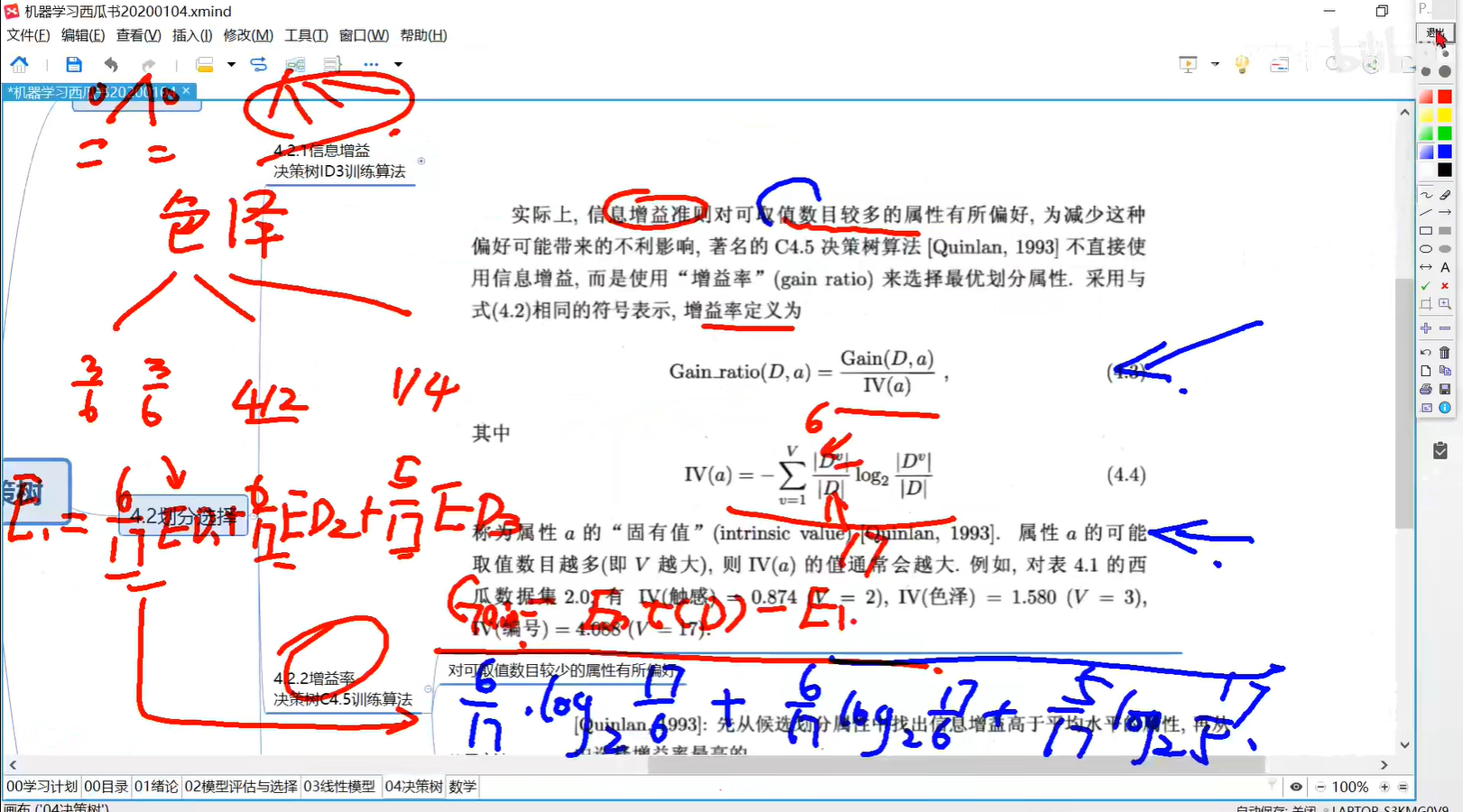

0407 增益率简述

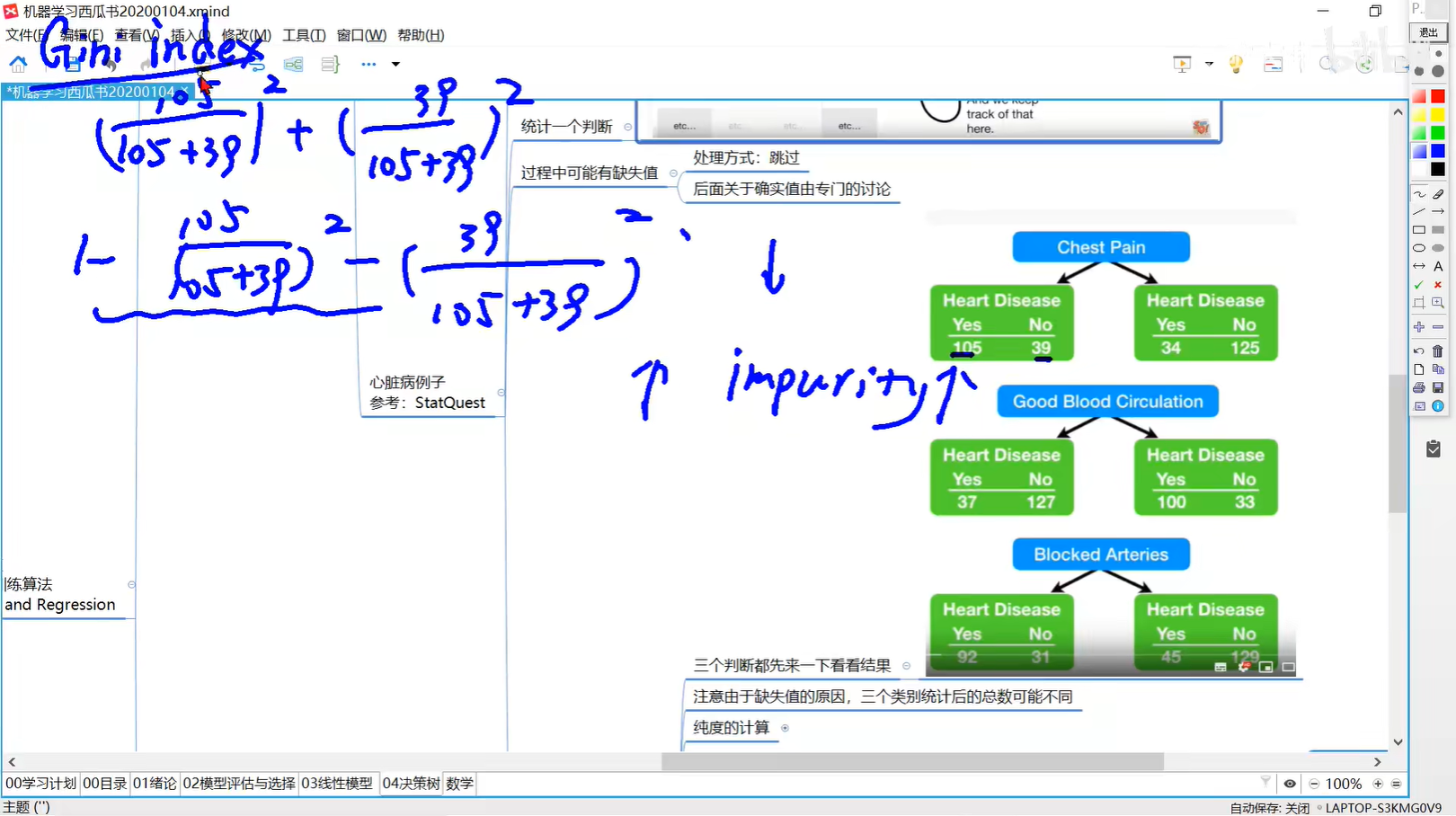

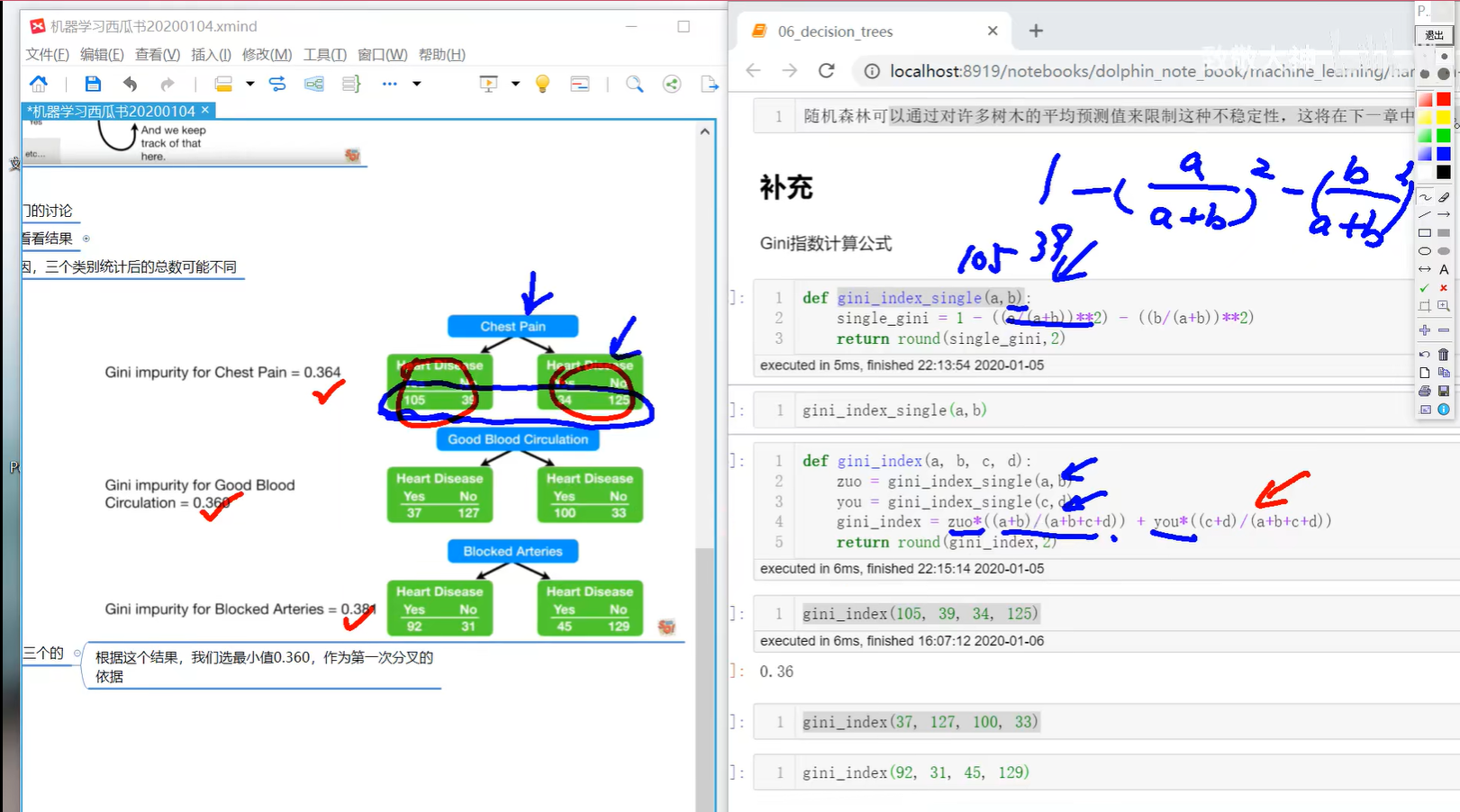

0408 决策树CART基尼指数

0409 基尼指数计算:第一次分叉

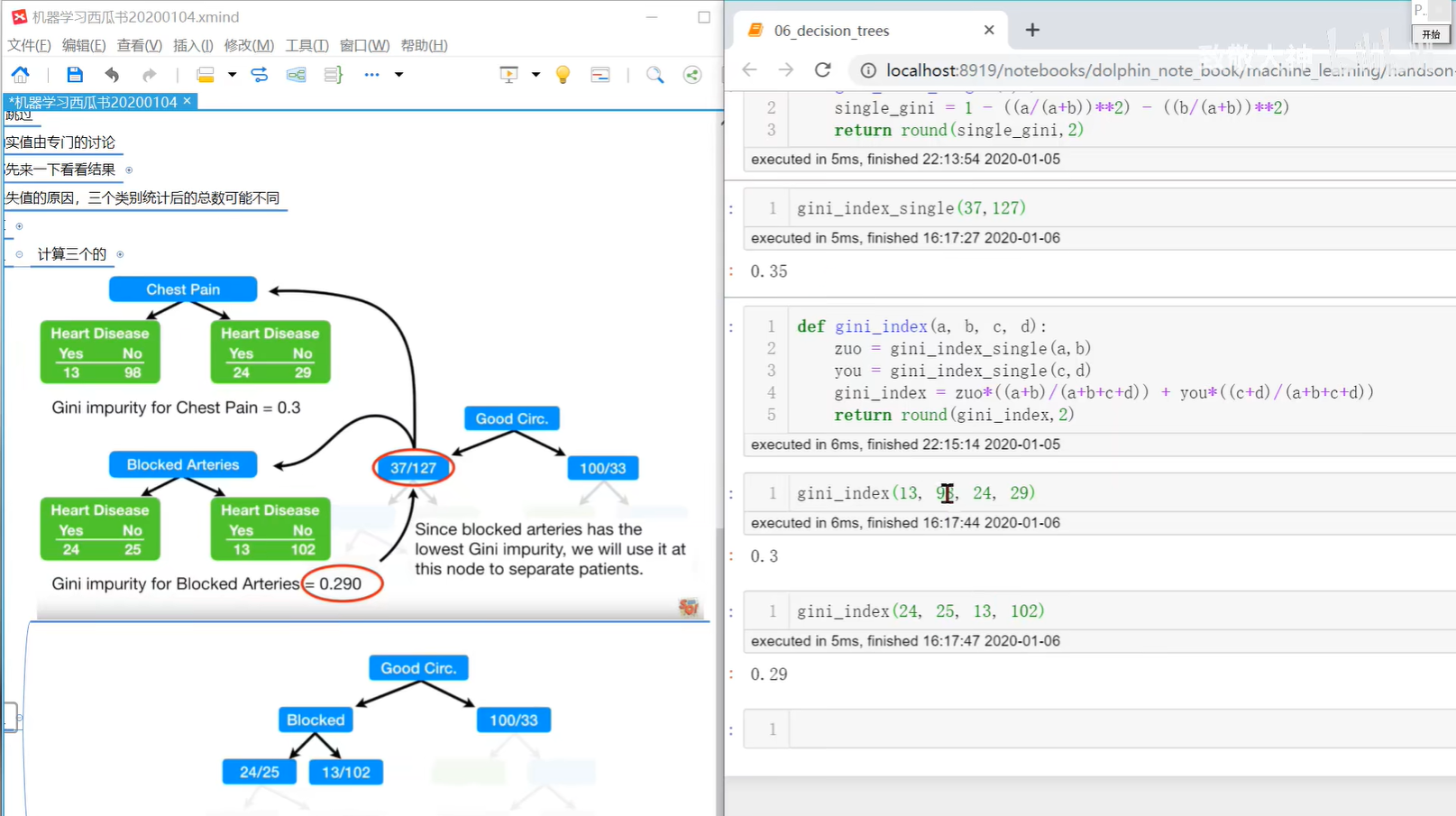

0410 基尼指数计算:第二次分叉

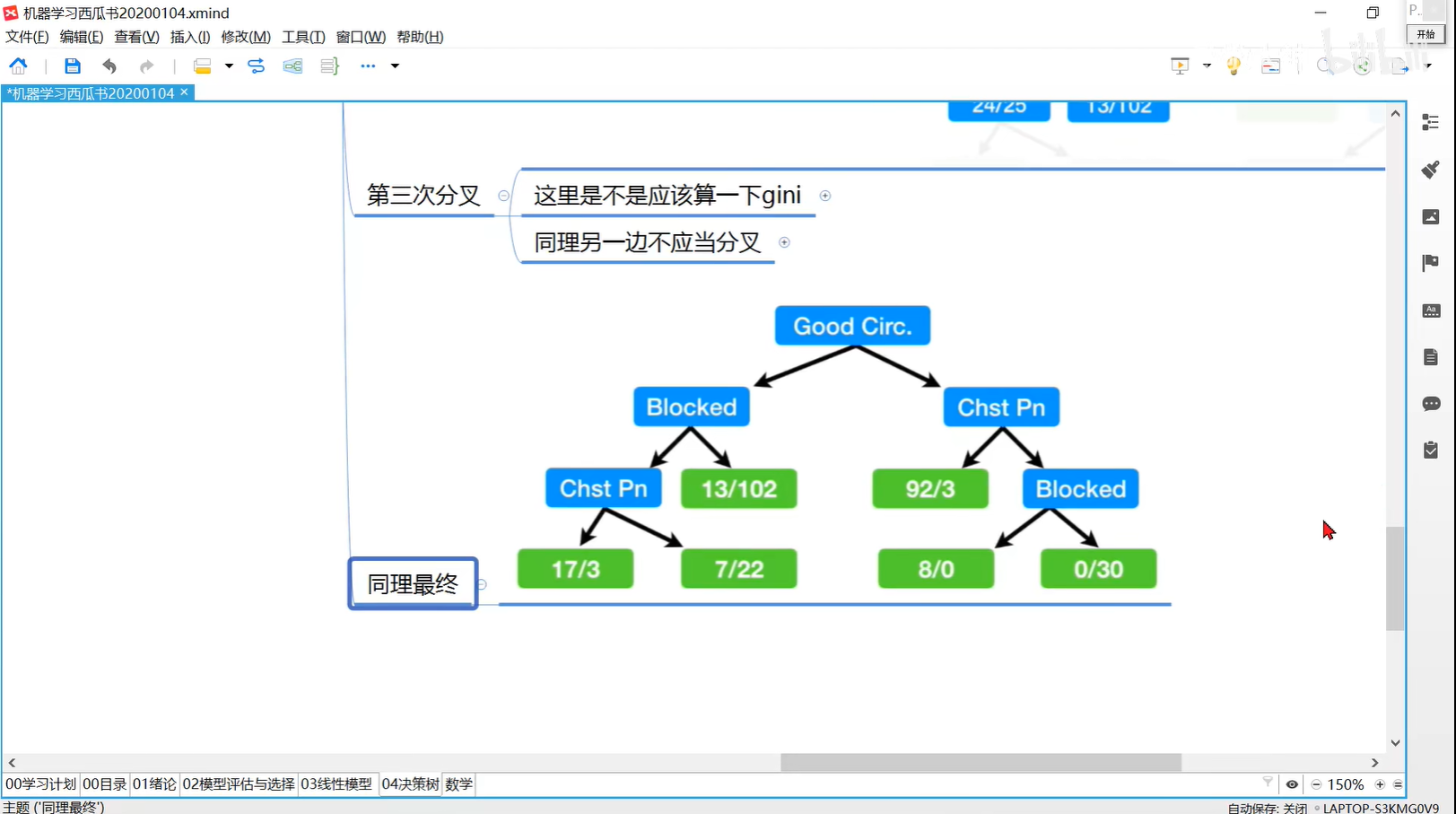

0411 基尼指数计算:第三次分叉与终止

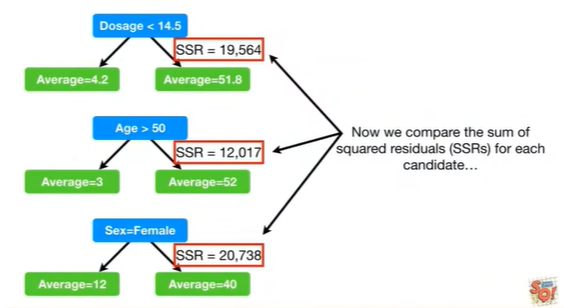

0412 CART算法回归树

多个特征,第一步算法SSR最小值

防止过拟合:如设定小于20不再分割

0413 剪枝处理

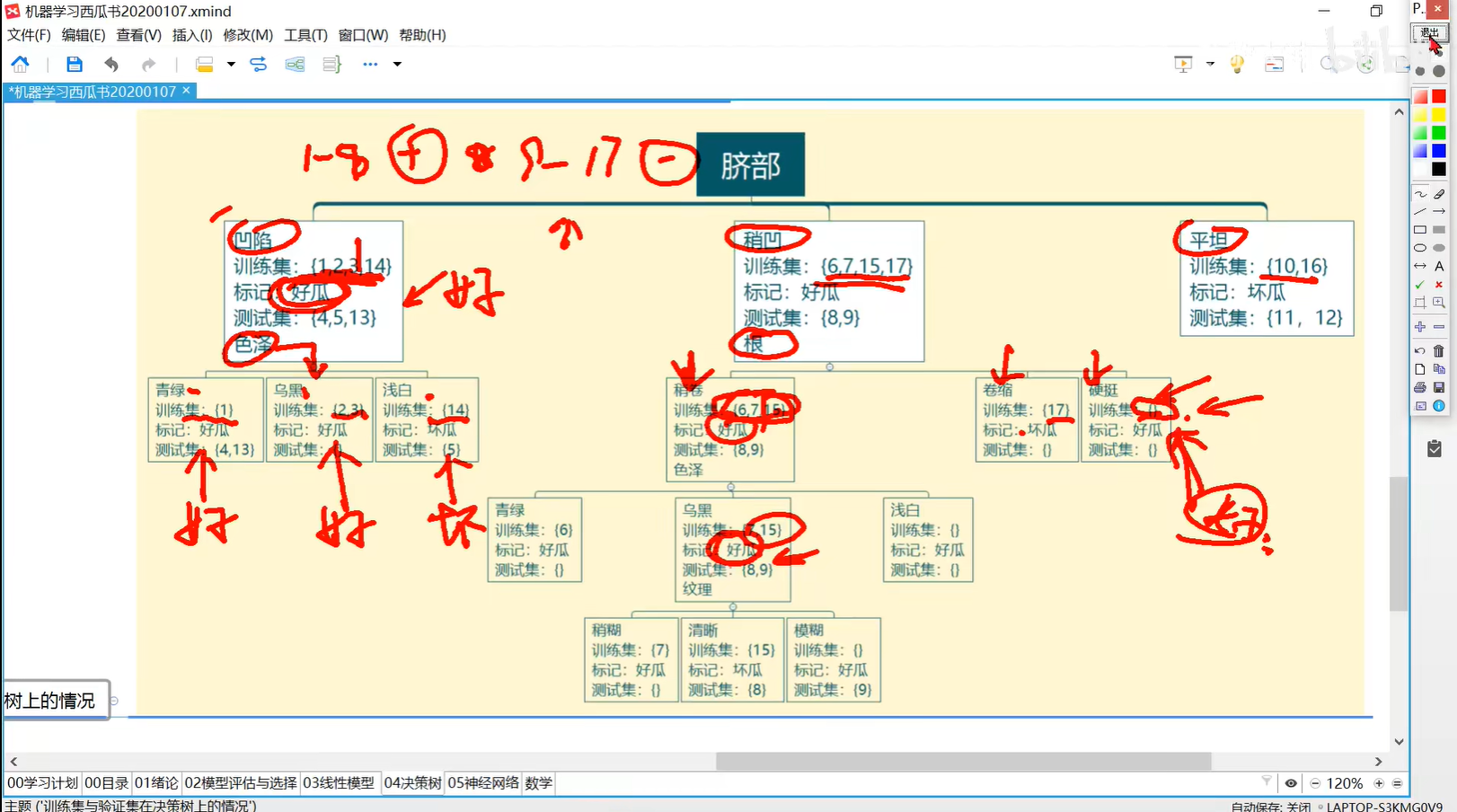

在训练集上使用信息增益得到决策树:

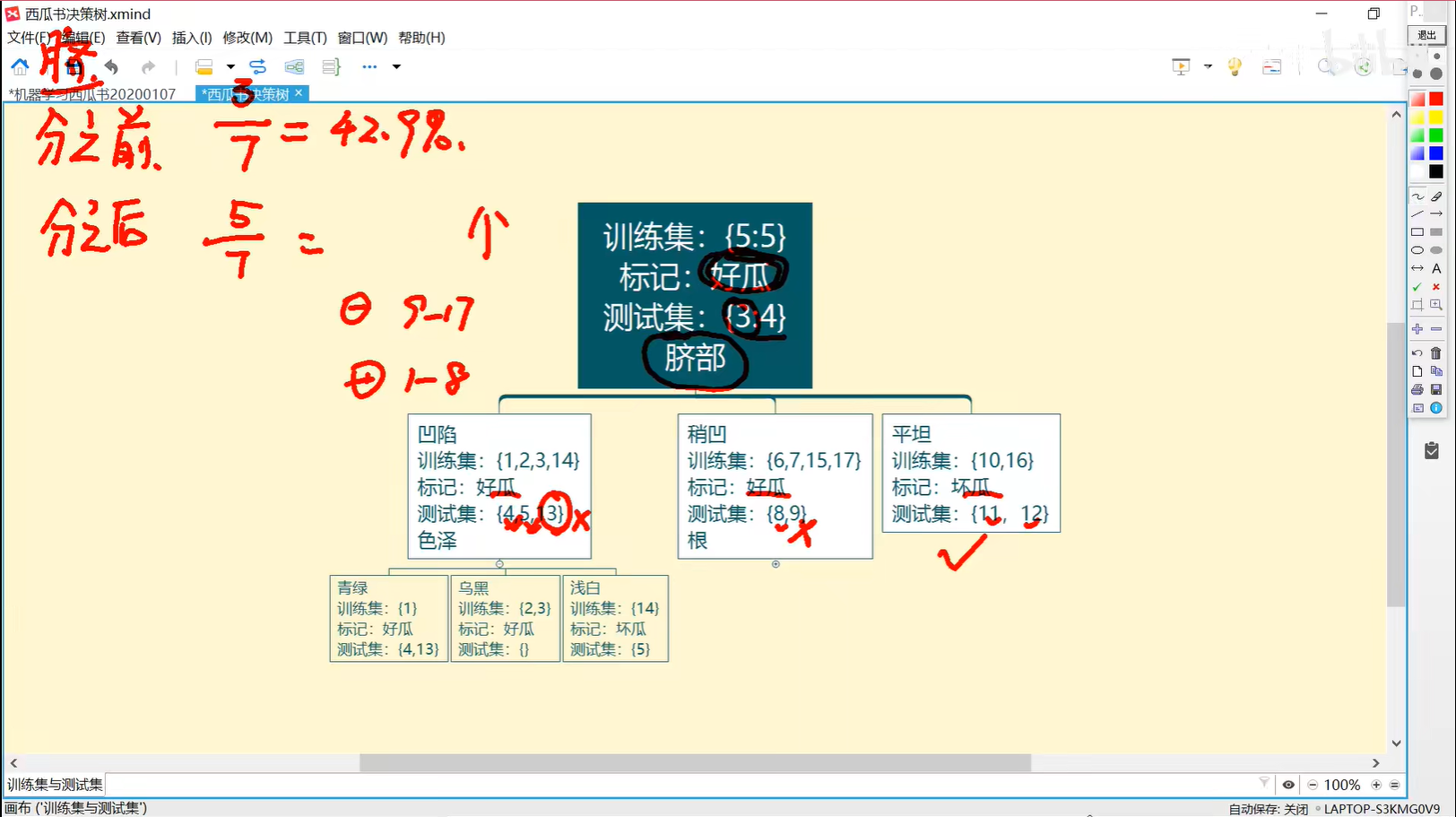

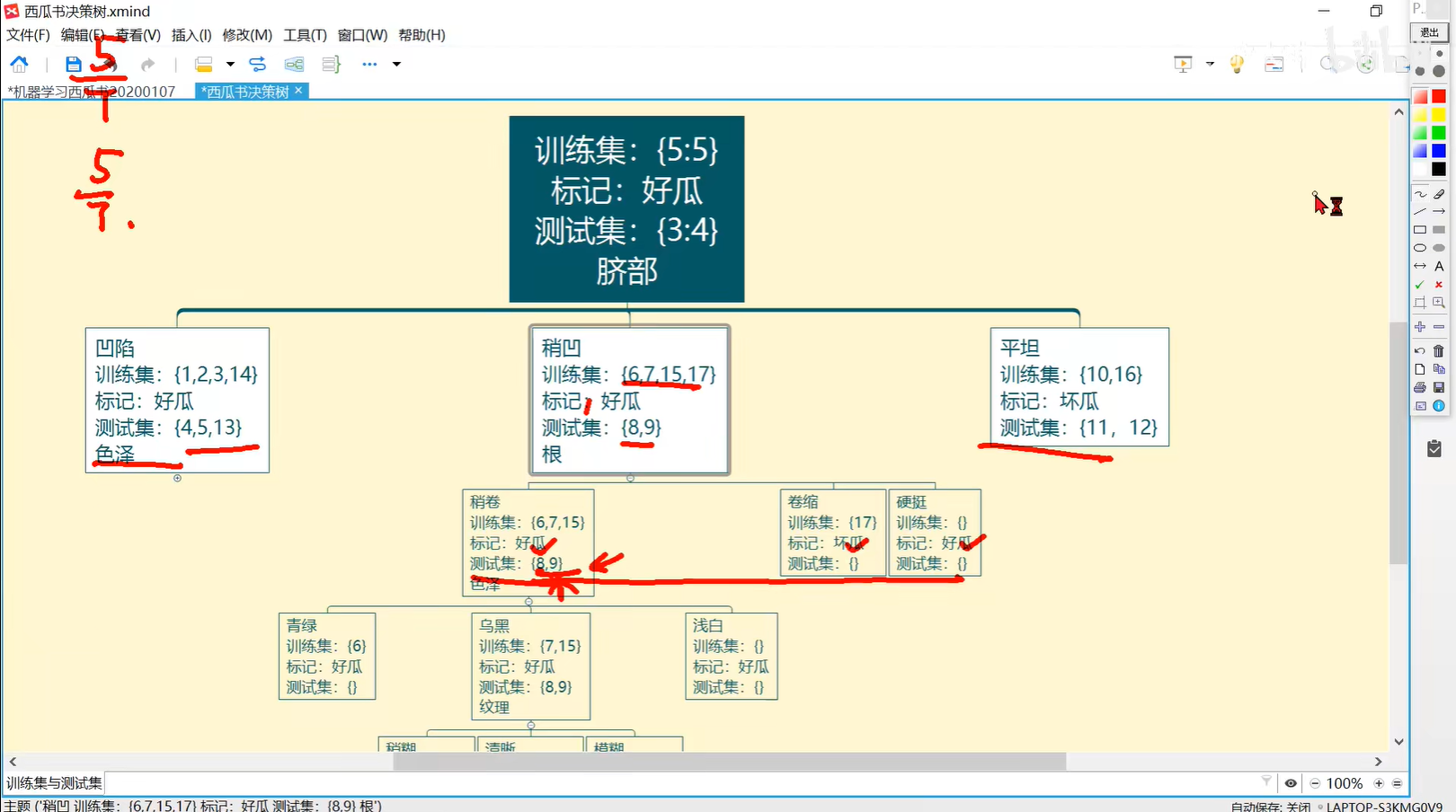

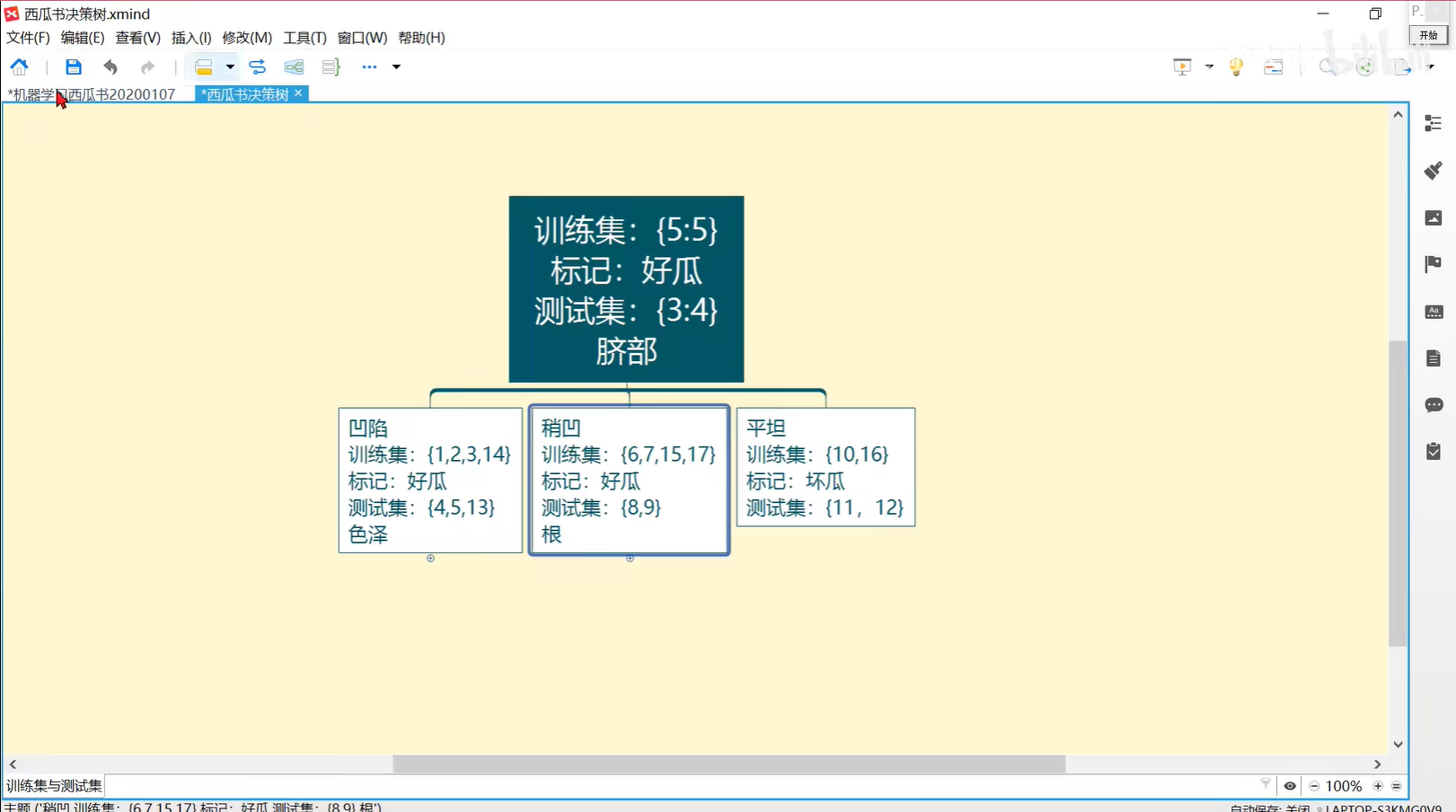

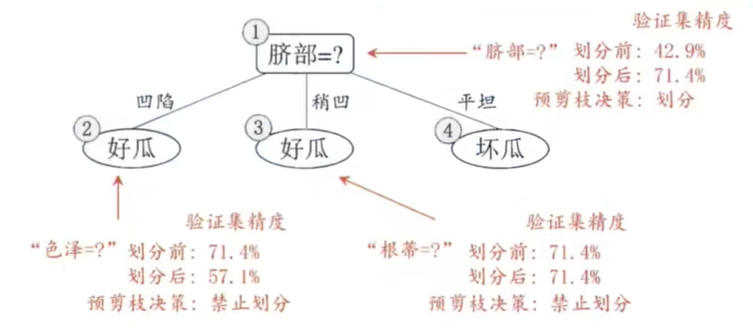

0414 预剪枝一

预剪枝是一种贪心算法,能剪就剪

0415 预剪枝二

最后这里,全部是坏瓜,所以也不再分

经过预剪枝,得到的图是:

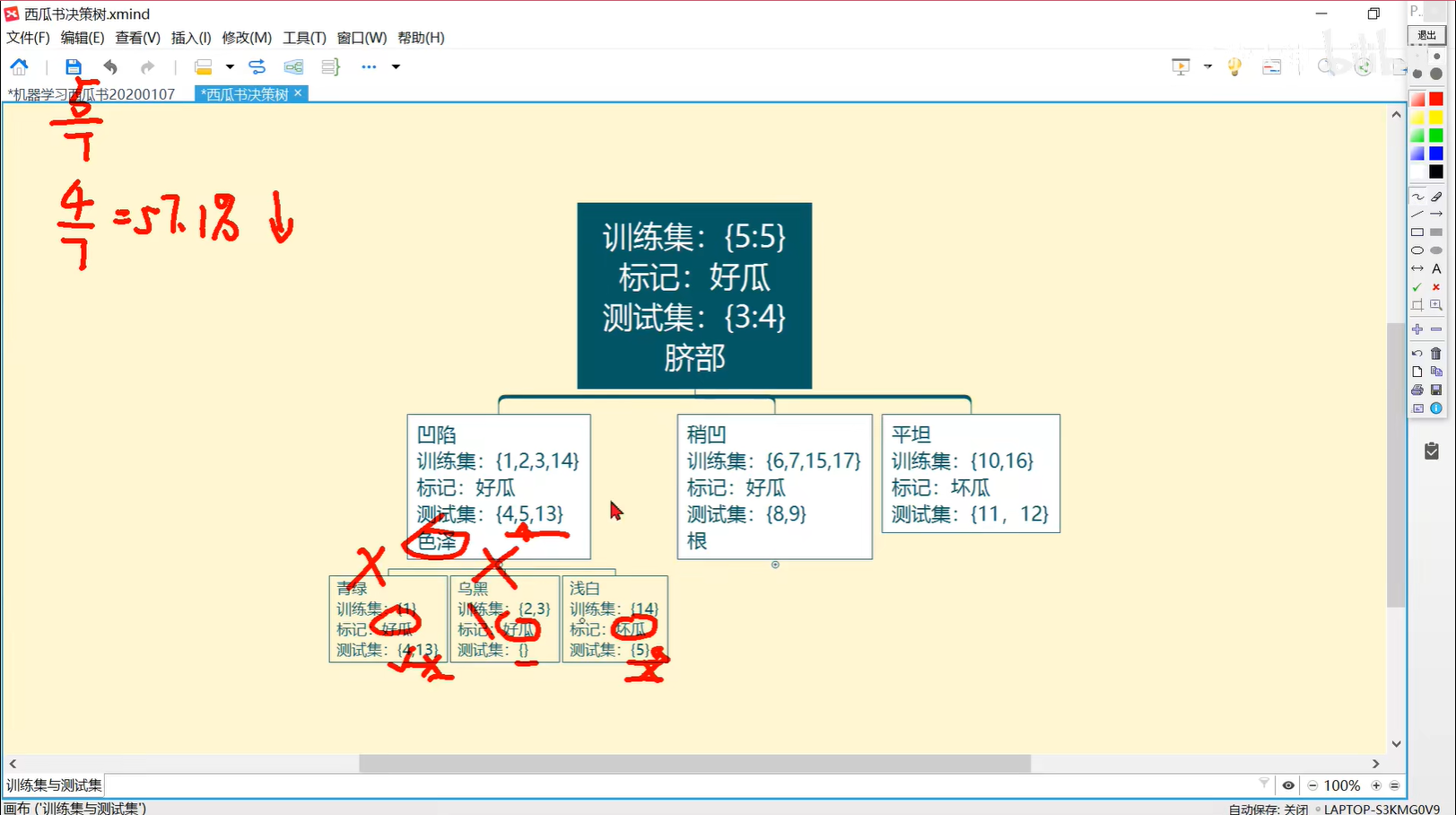

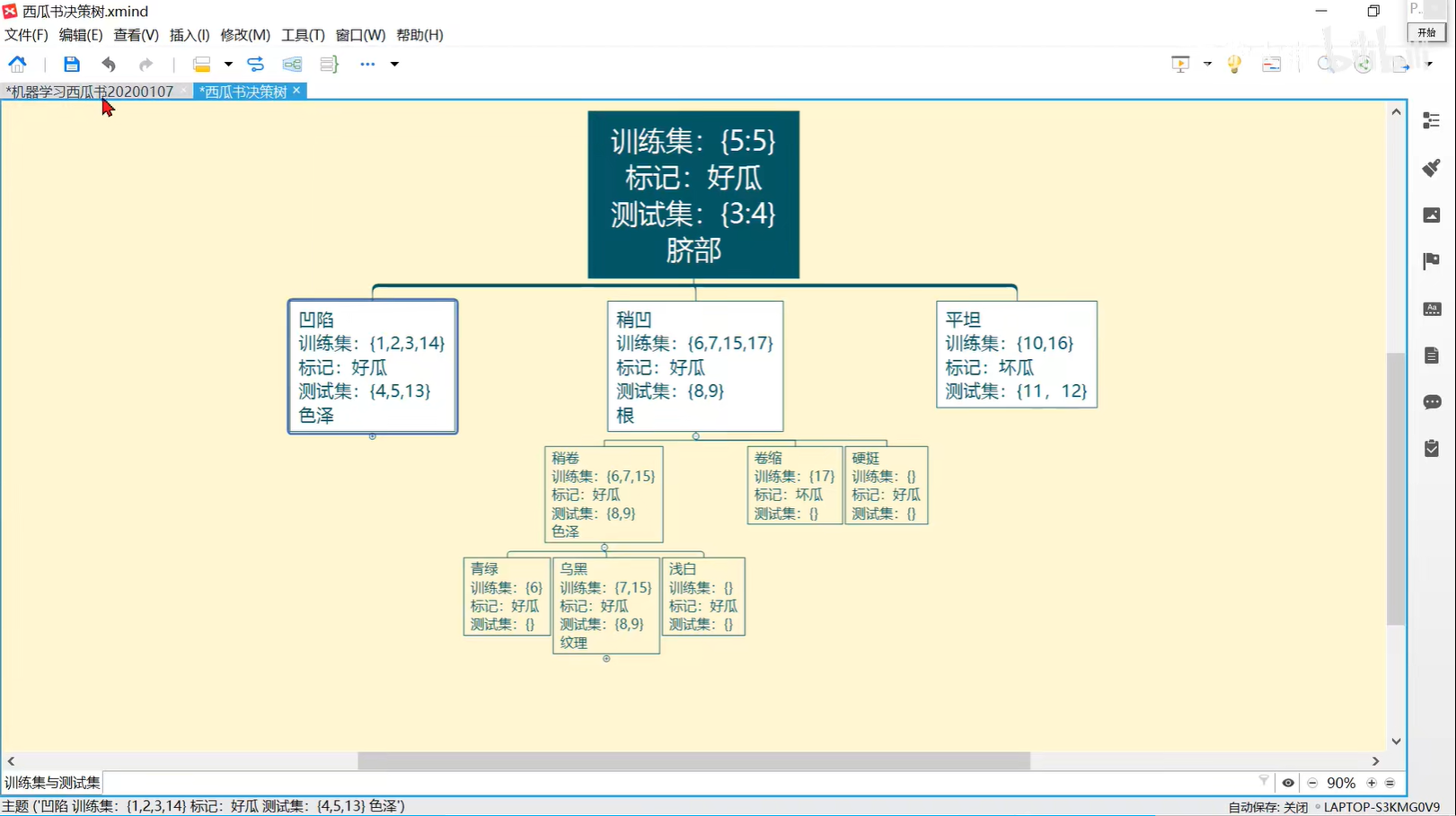

0416 后剪枝

后剪枝是能不剪就不剪

最终是:

补充:Prune Regression trees

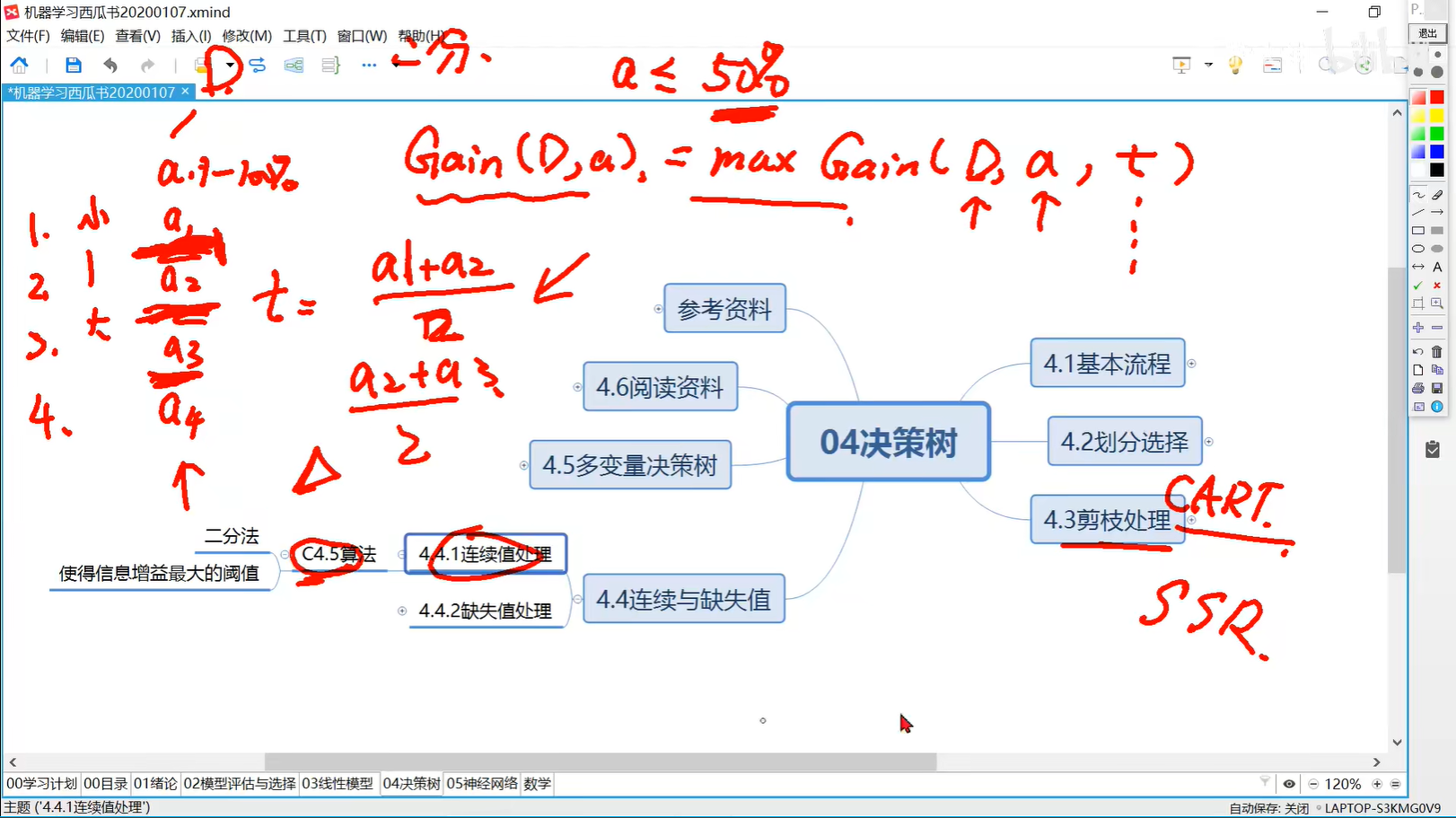

0417 连续值C4.5二分法信息增益最大准则

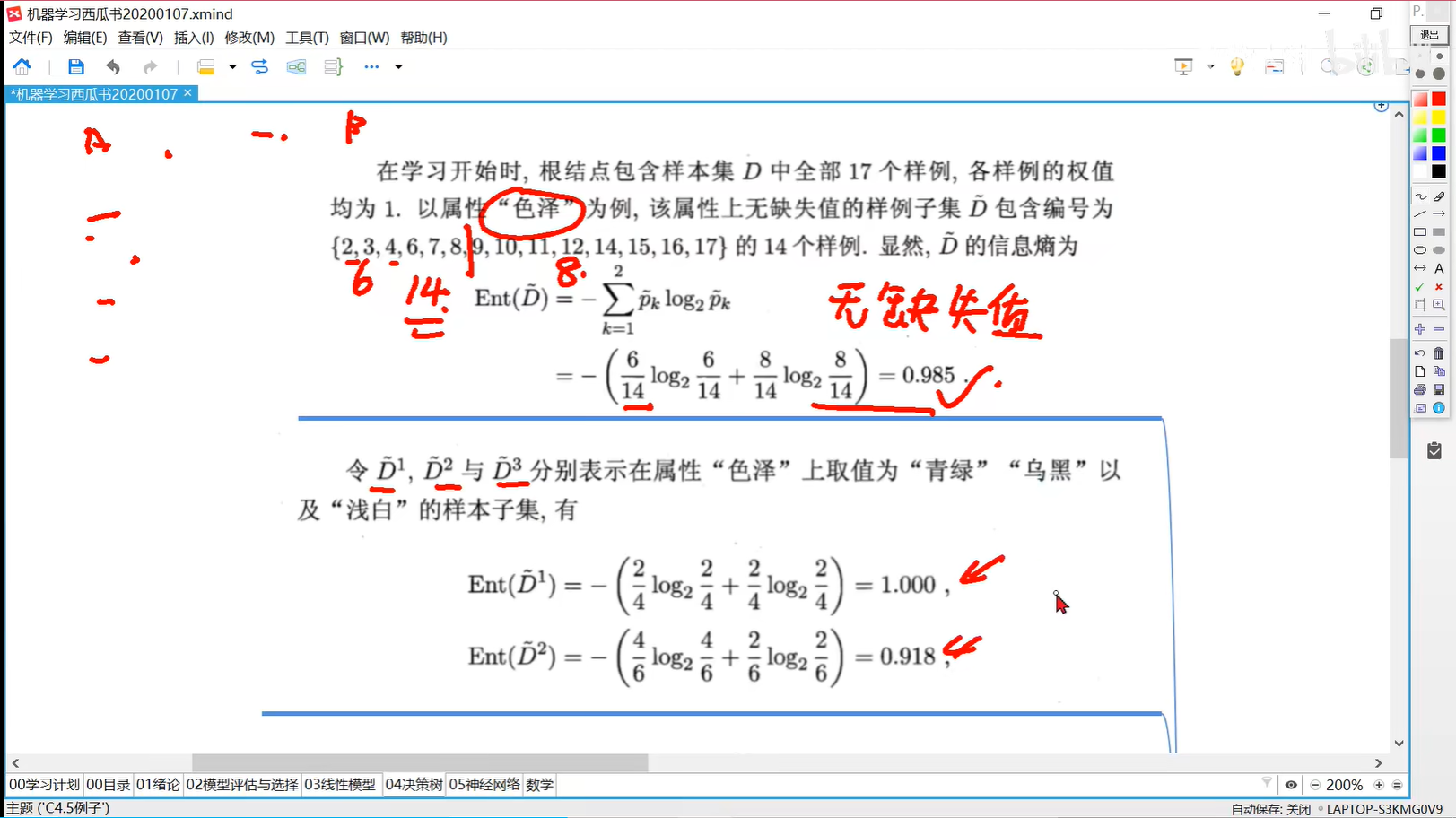

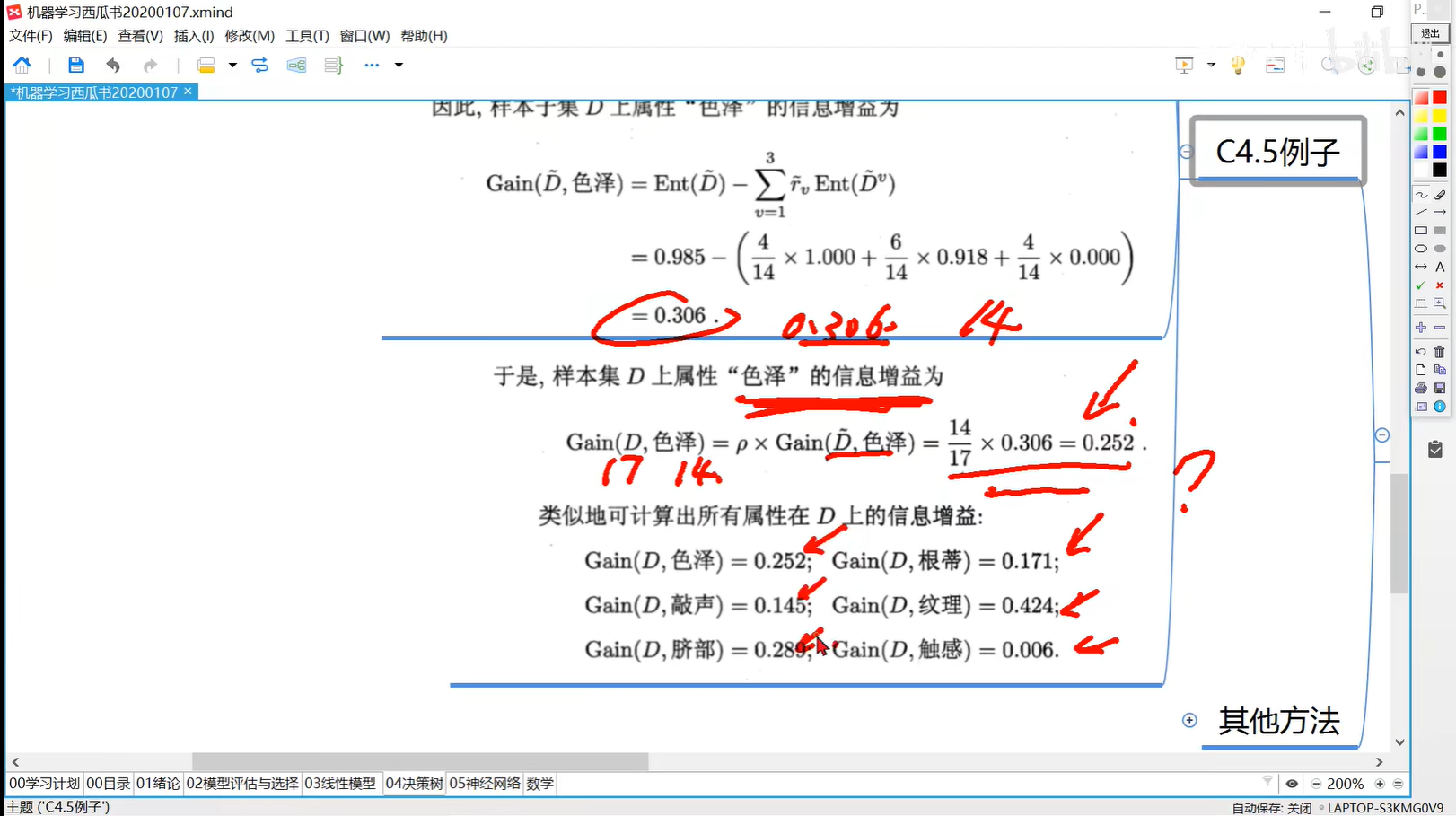

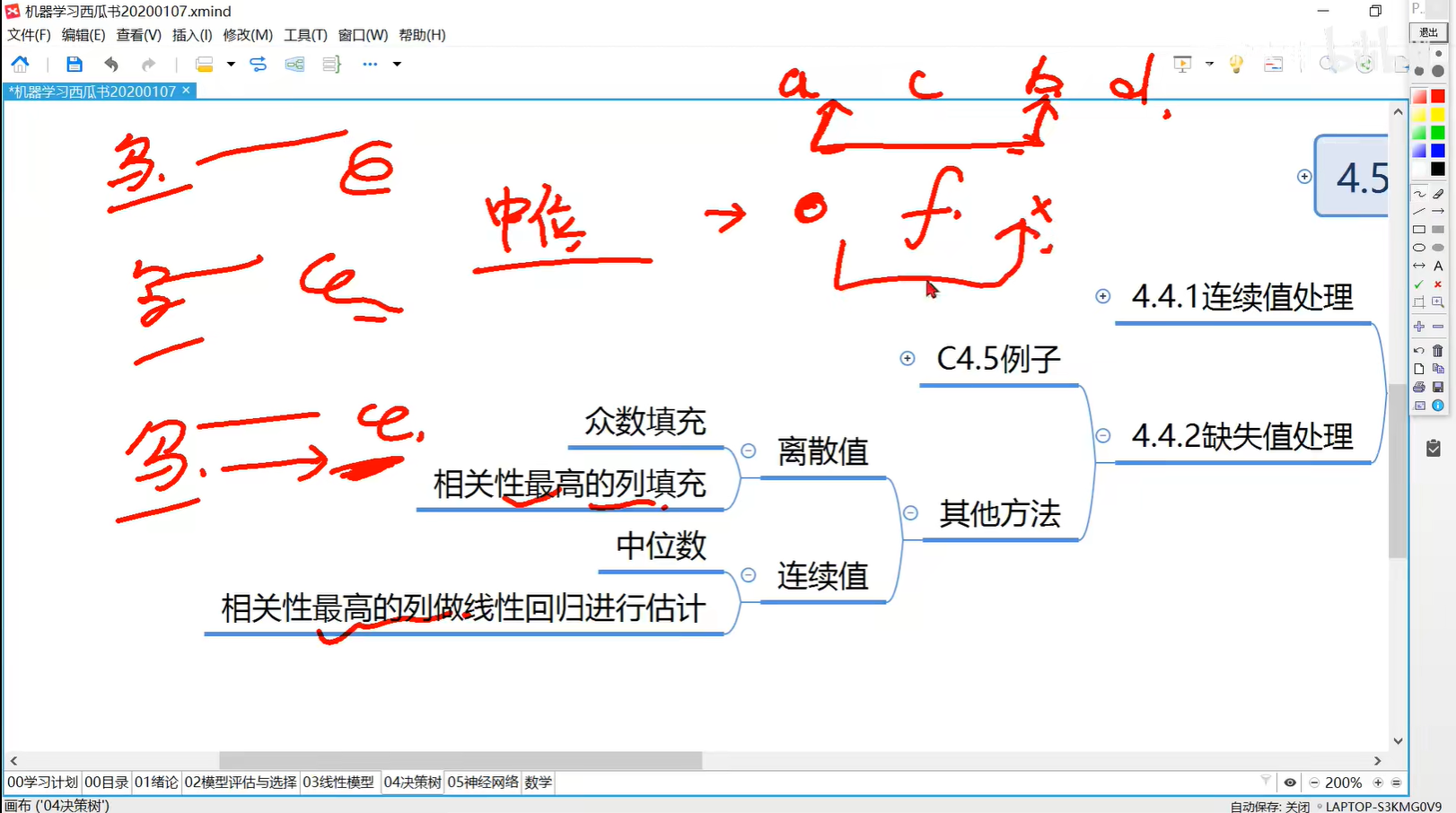

0418 决策树缺失值处理

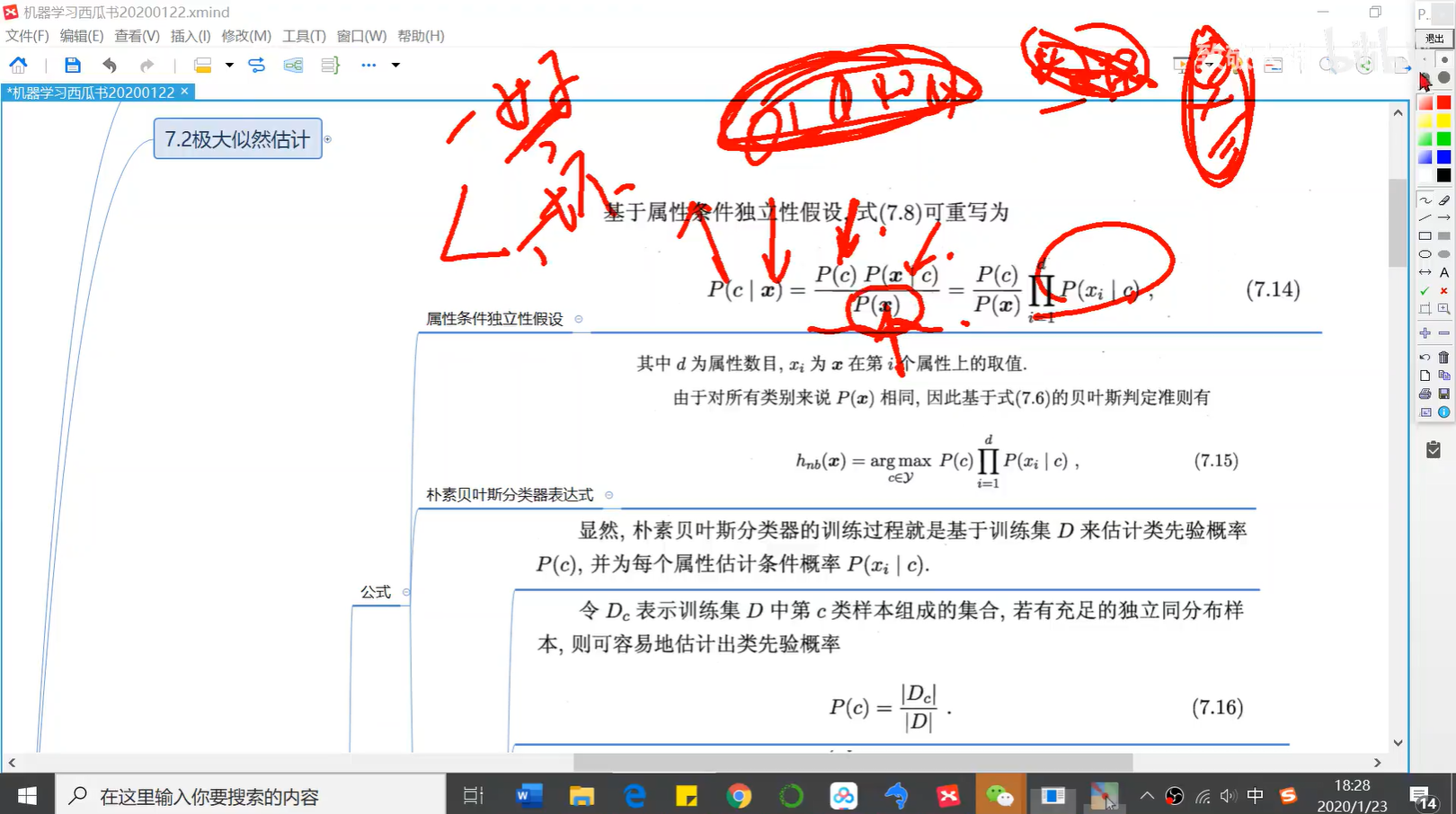

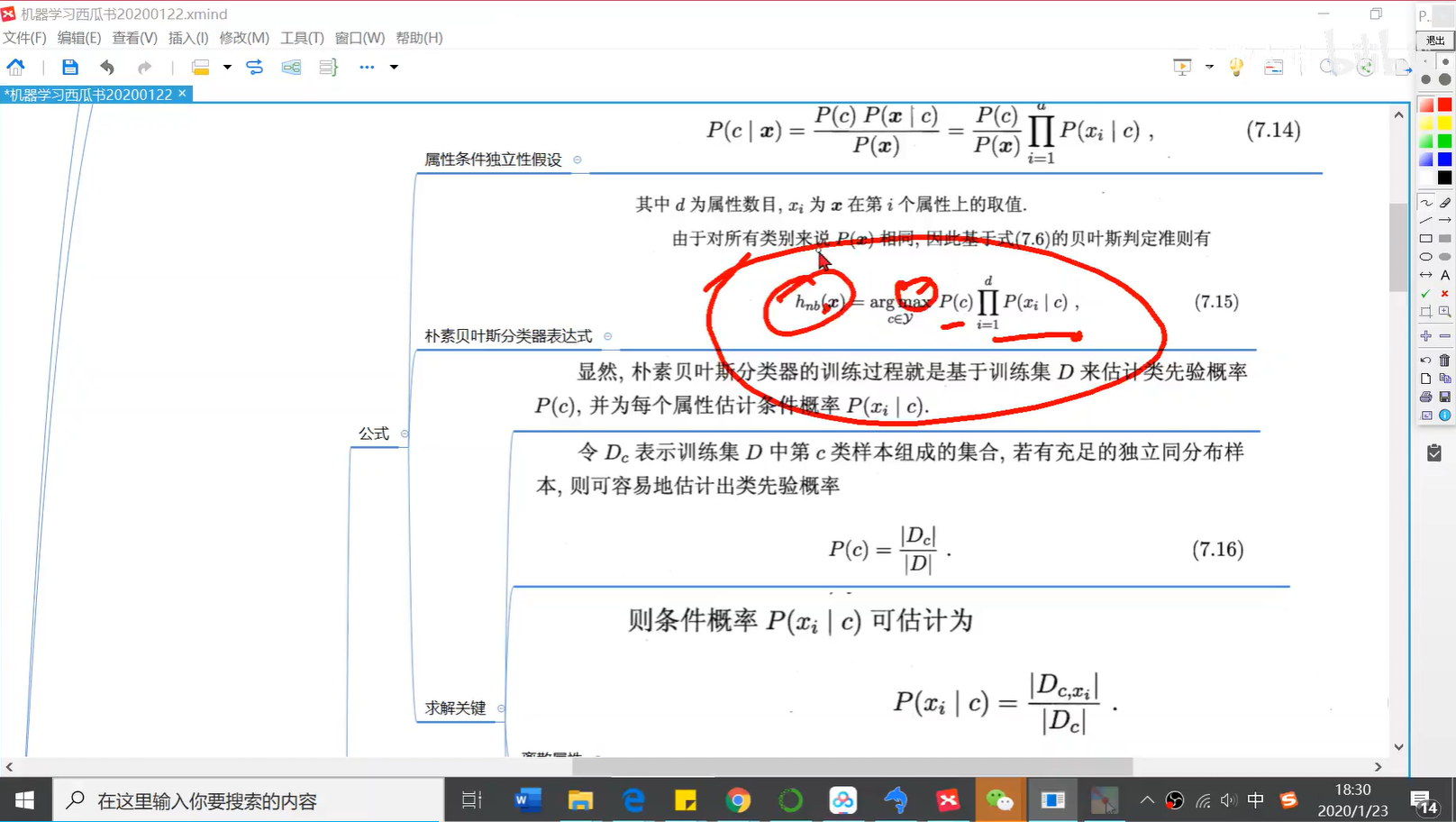

0701 贝叶斯分类器综述

0702 贝叶斯定理—一个应用

https://www.matongxue.com/madocs/279/

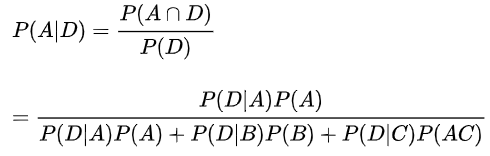

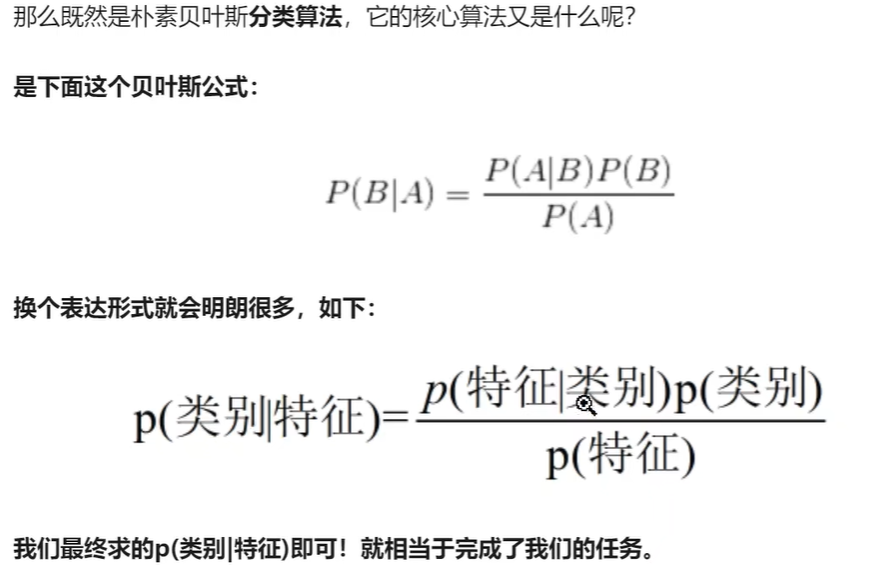

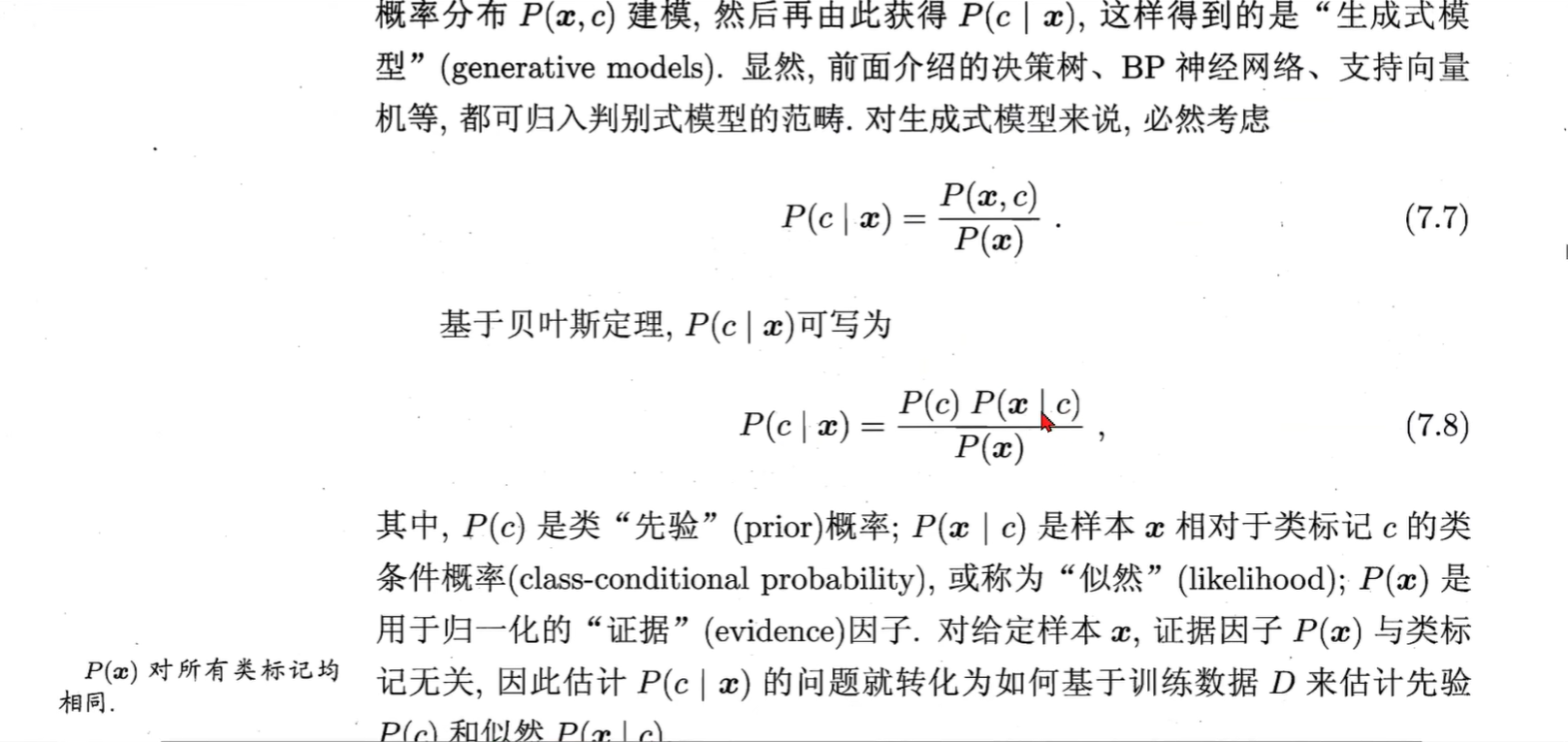

0703 贝叶斯定理

https://www.matongxue.com/madocs/279/

0704 预热——一个半朴素贝叶斯的例子

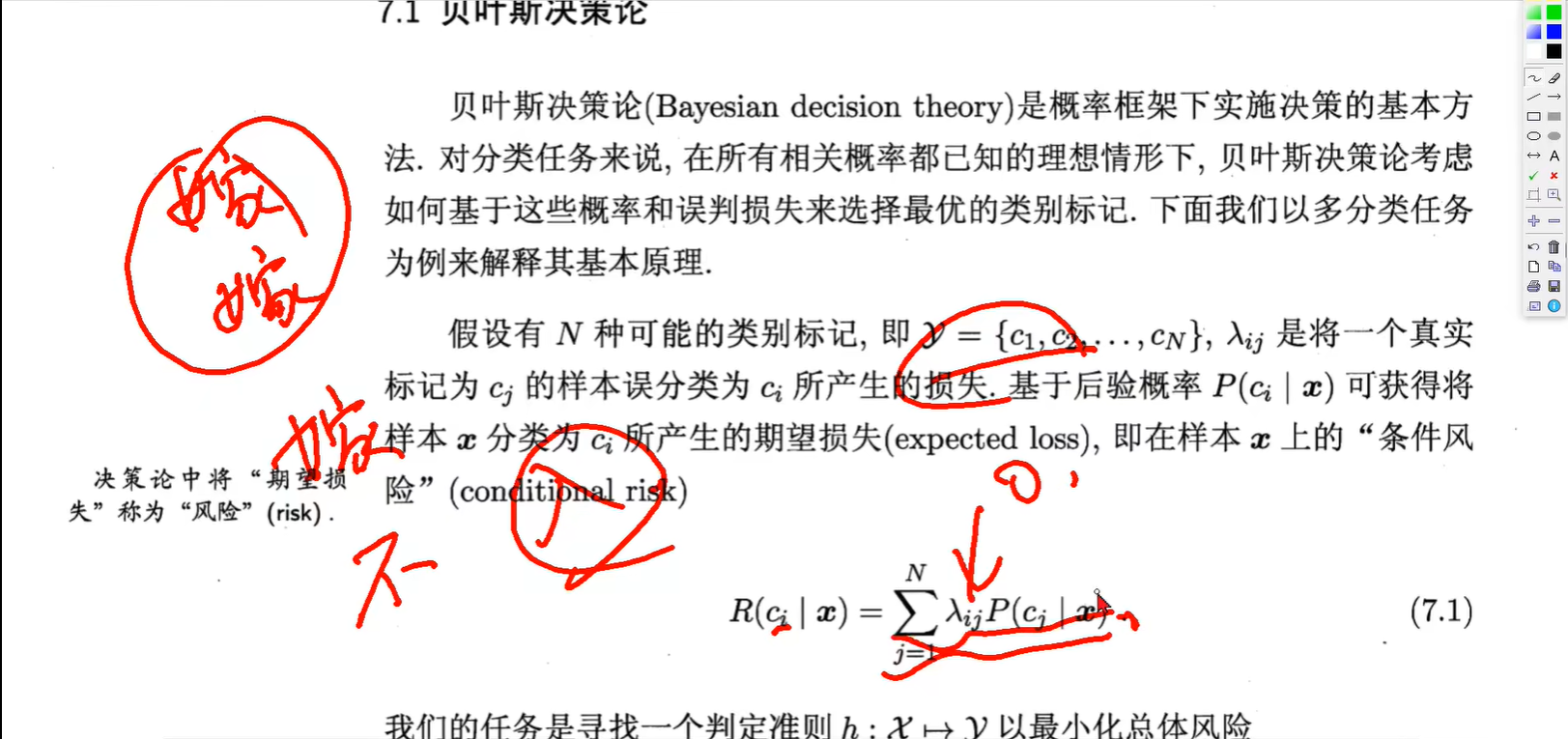

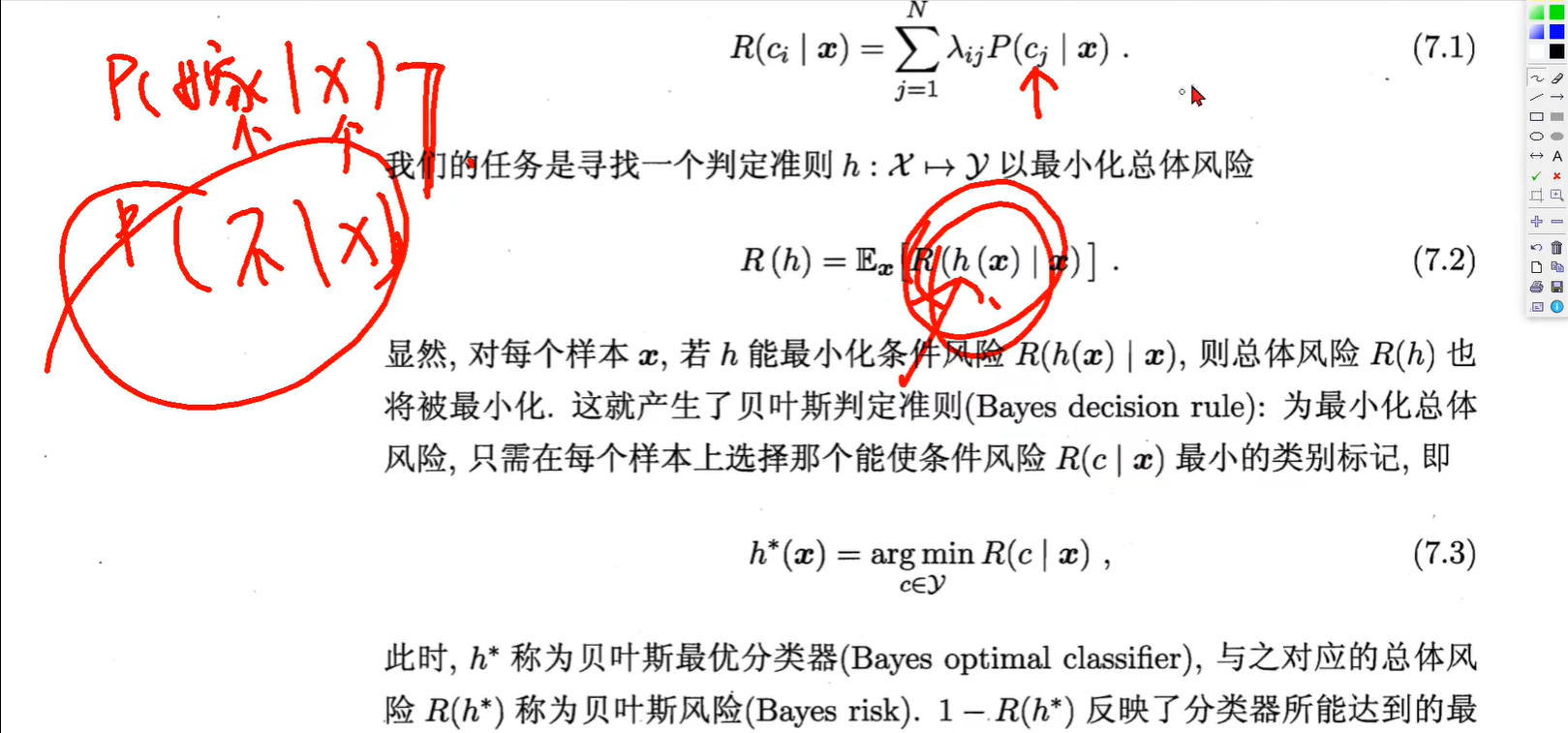

0705贝叶斯决策论

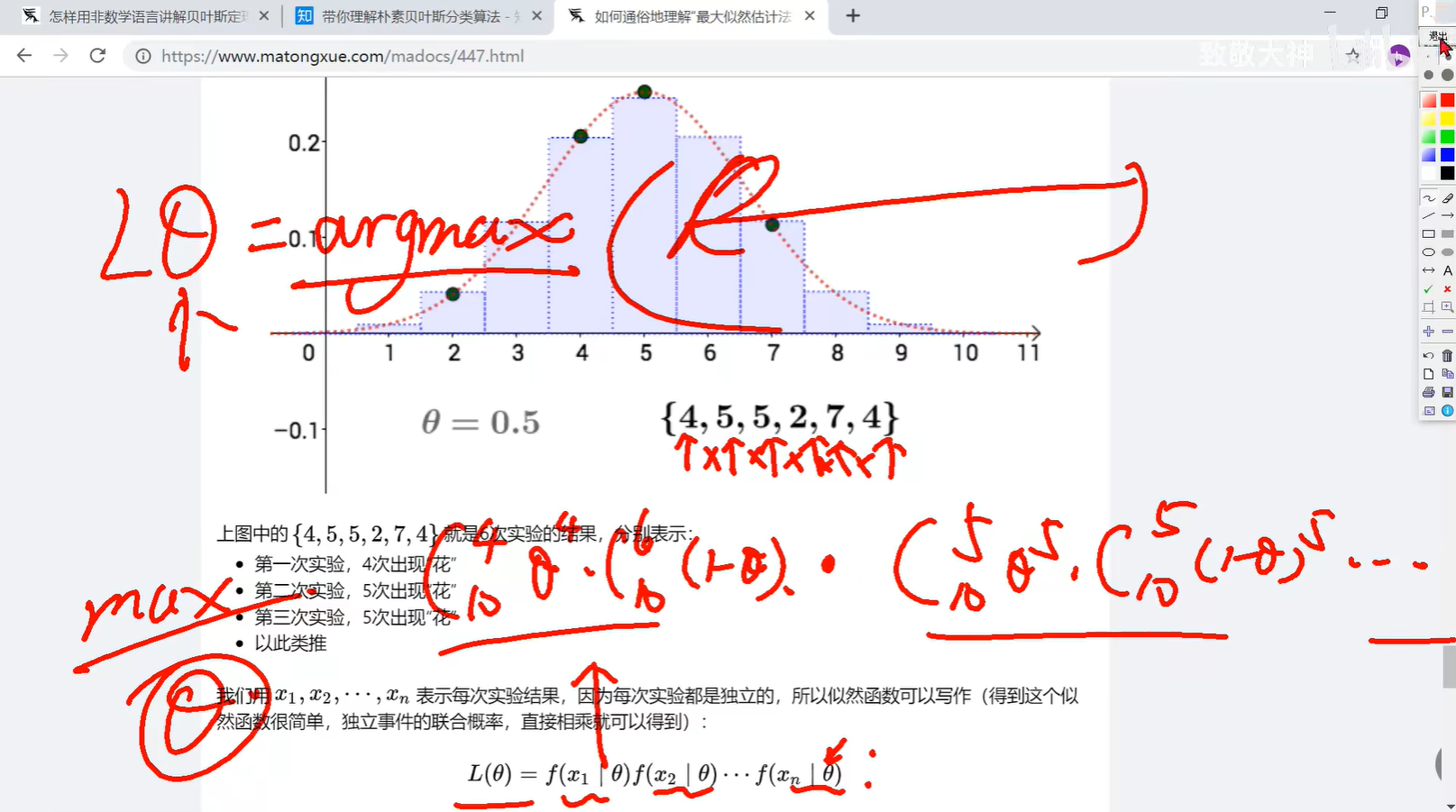

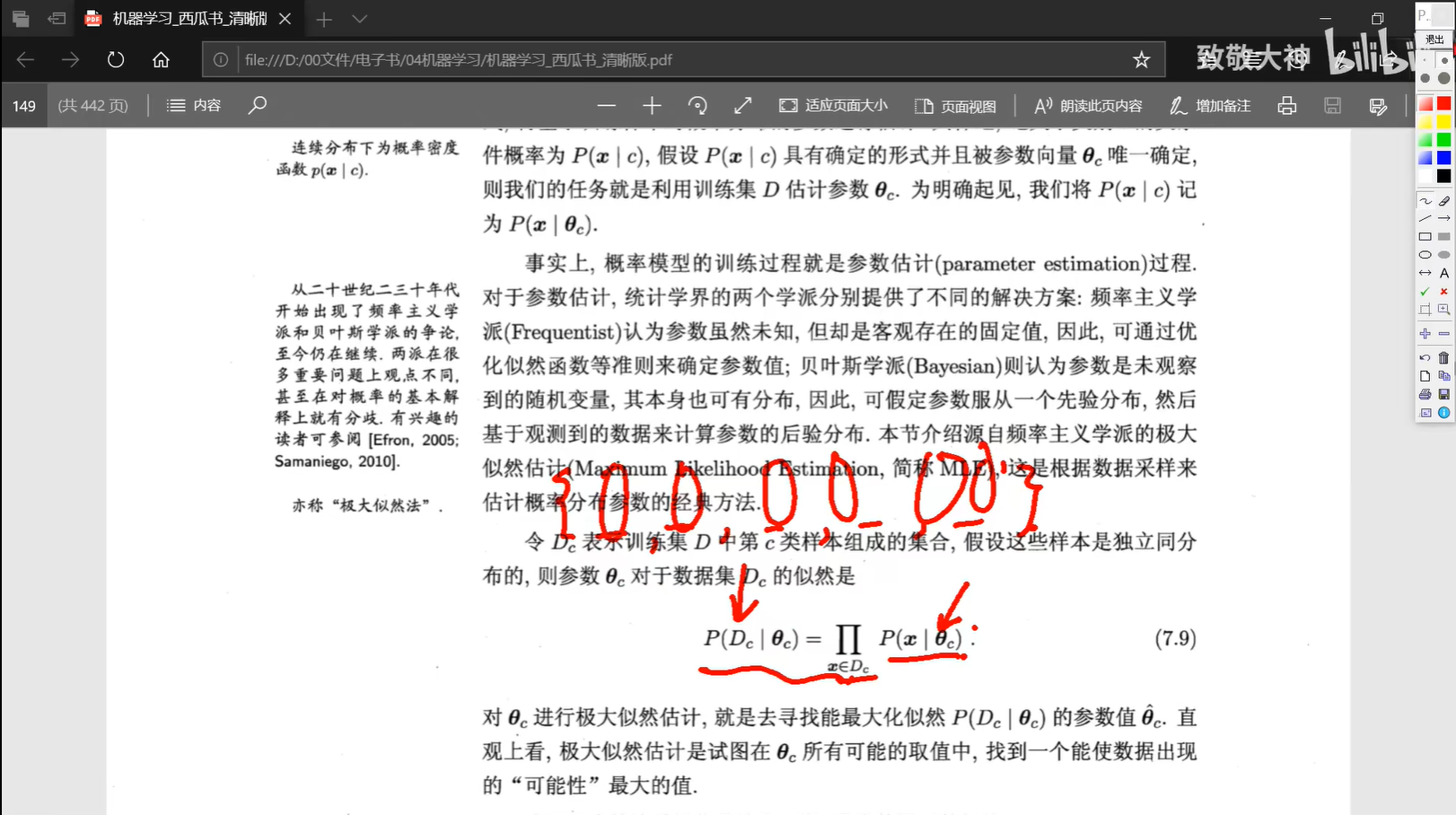

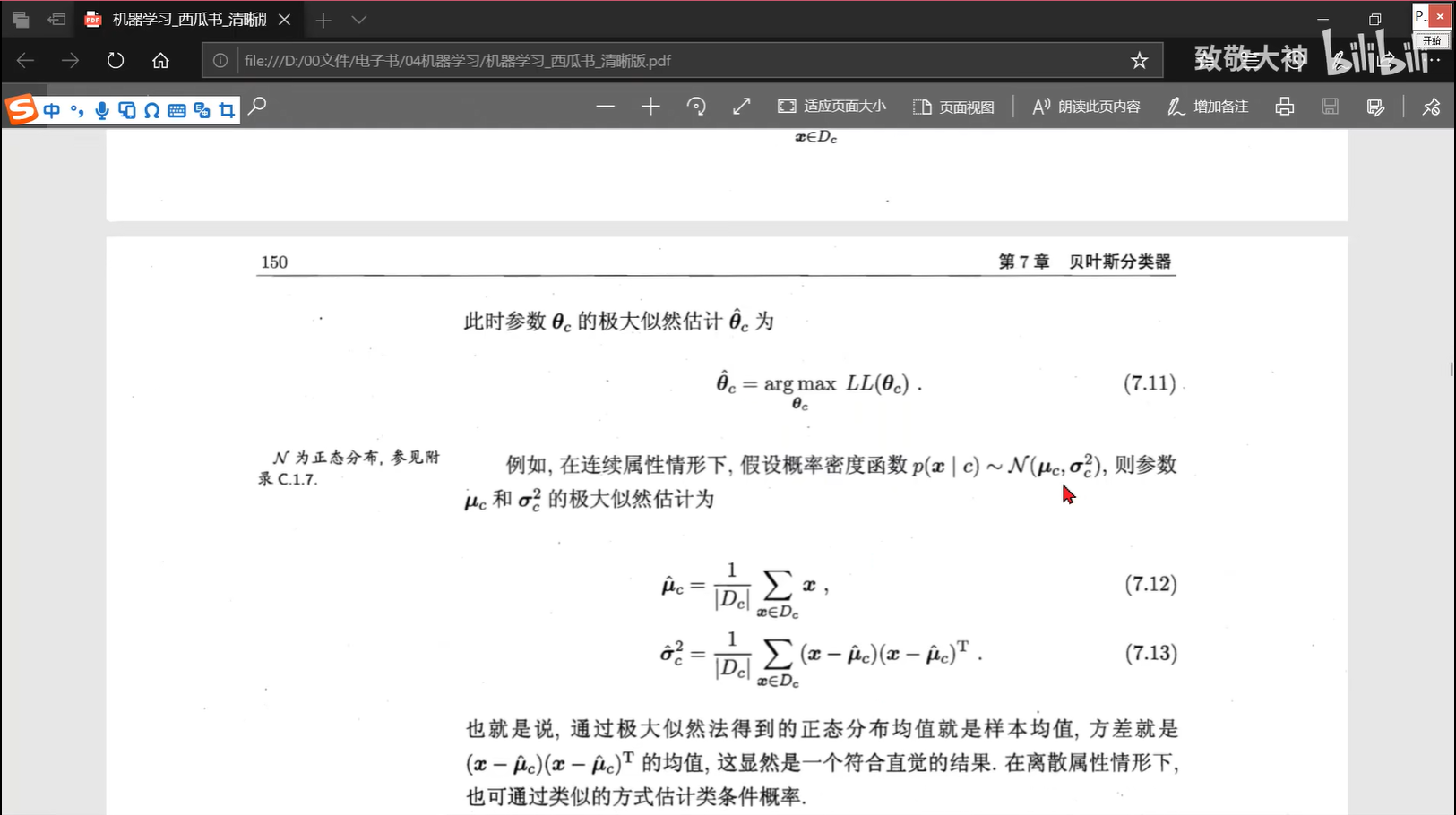

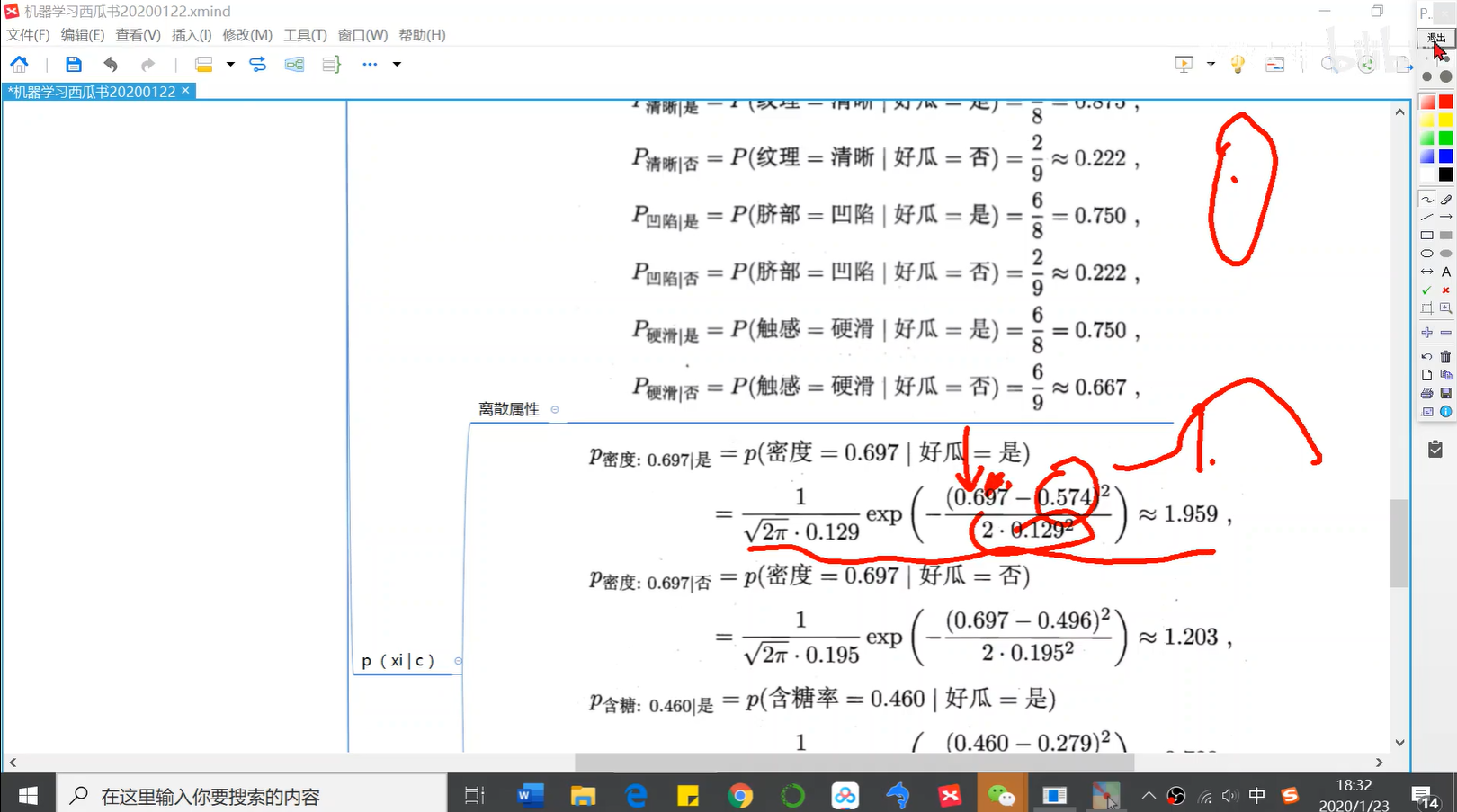

0706 最大似然估计

https://www.matongxue.com/madocs/447/

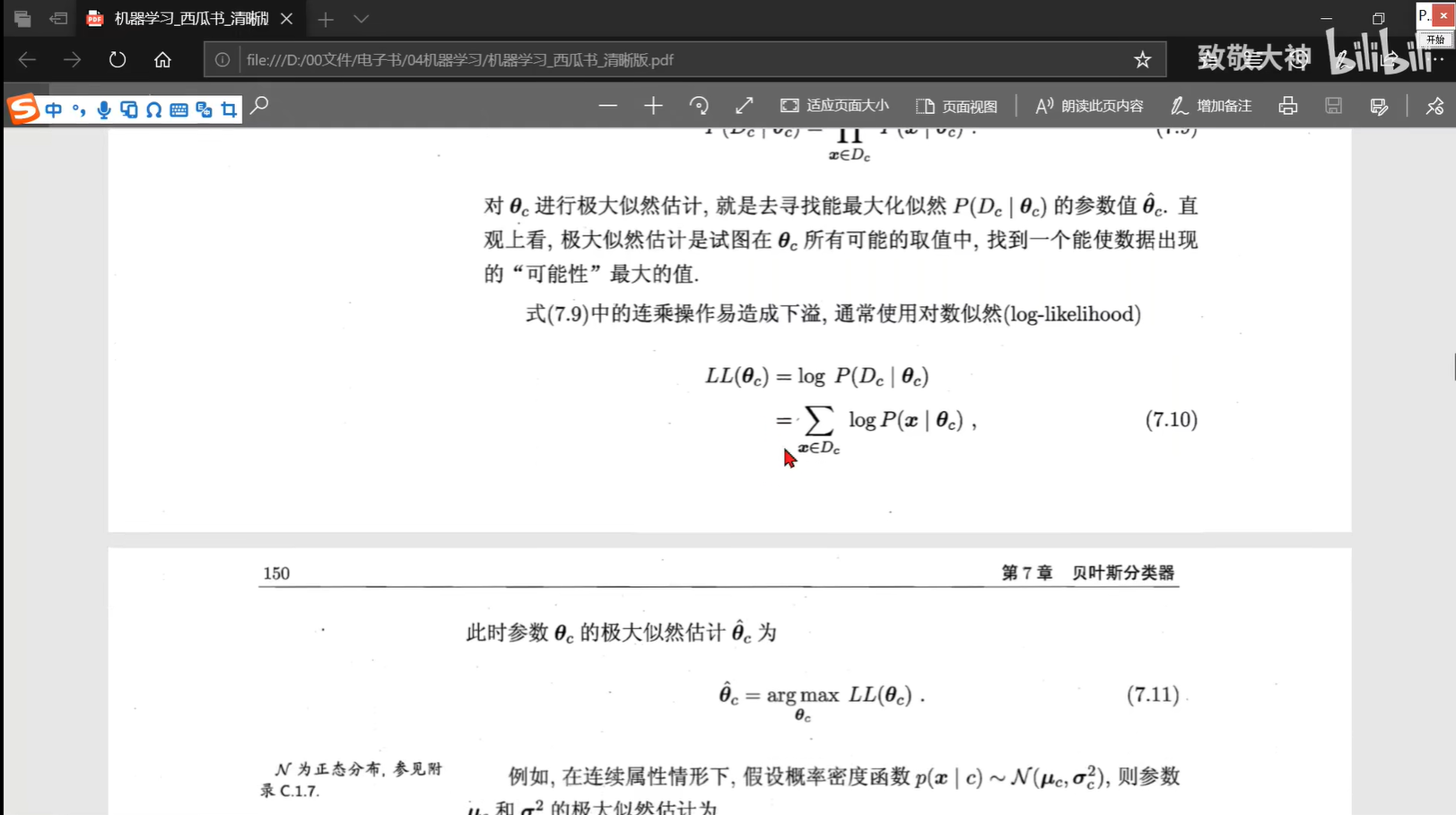

0709 最大似然估计——公式与取对数

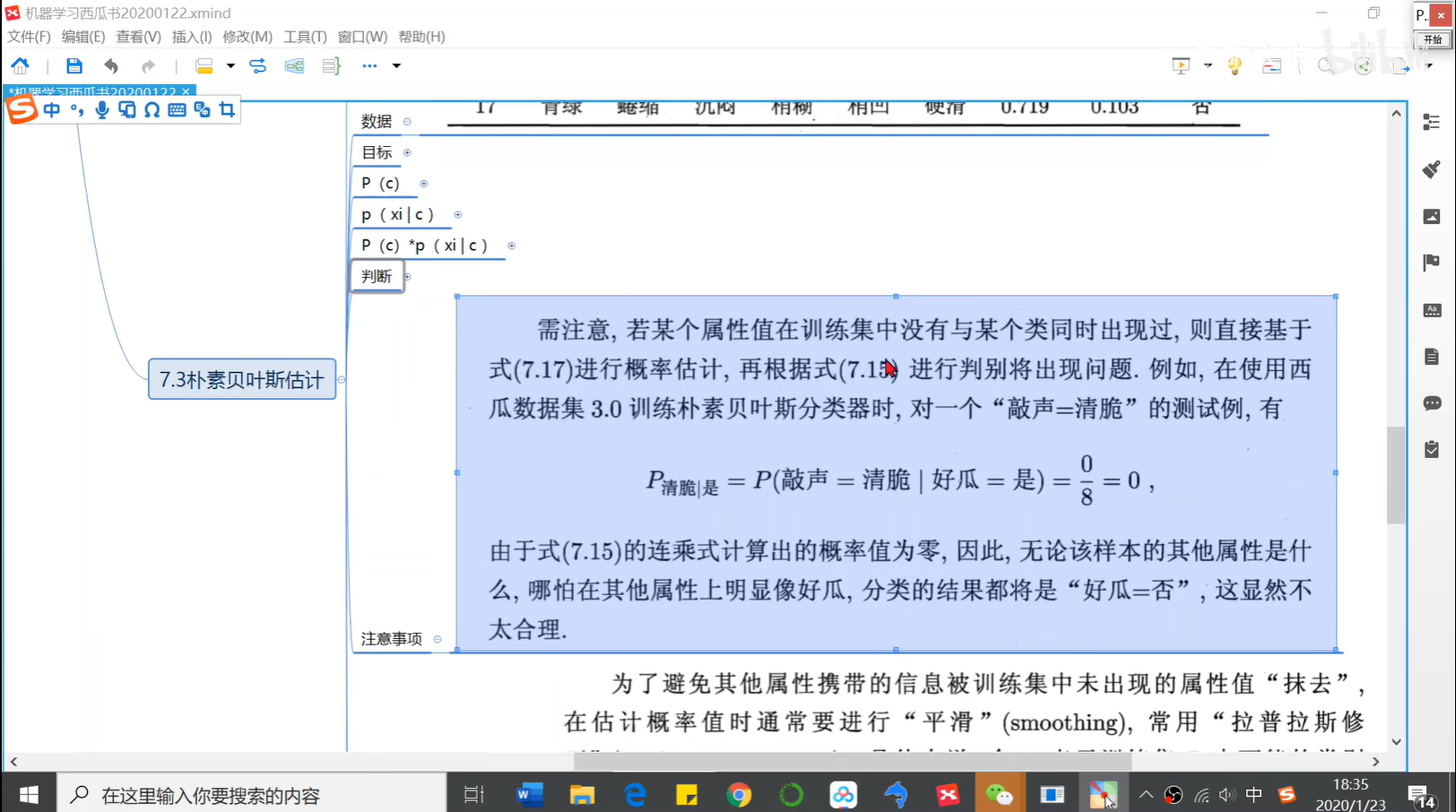

0711 拉普拉斯修正

拉普拉斯修正避免了因为训练集不充分而导致的概率估计为0的情况

拉普拉斯修正实际上是假设了属性值与类别均匀分布,这是在朴素贝叶斯学习过程中额外引入的关于数据的先验

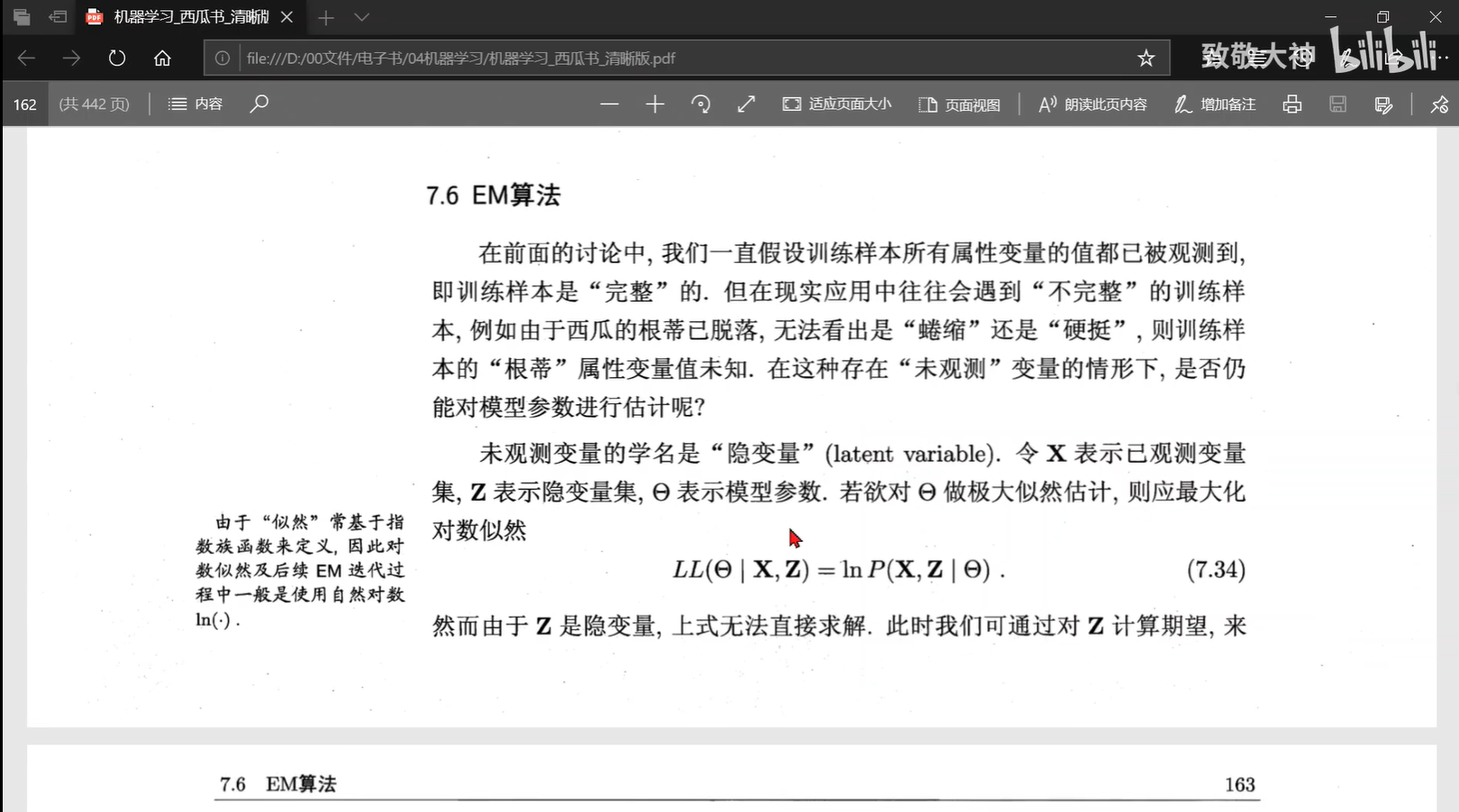

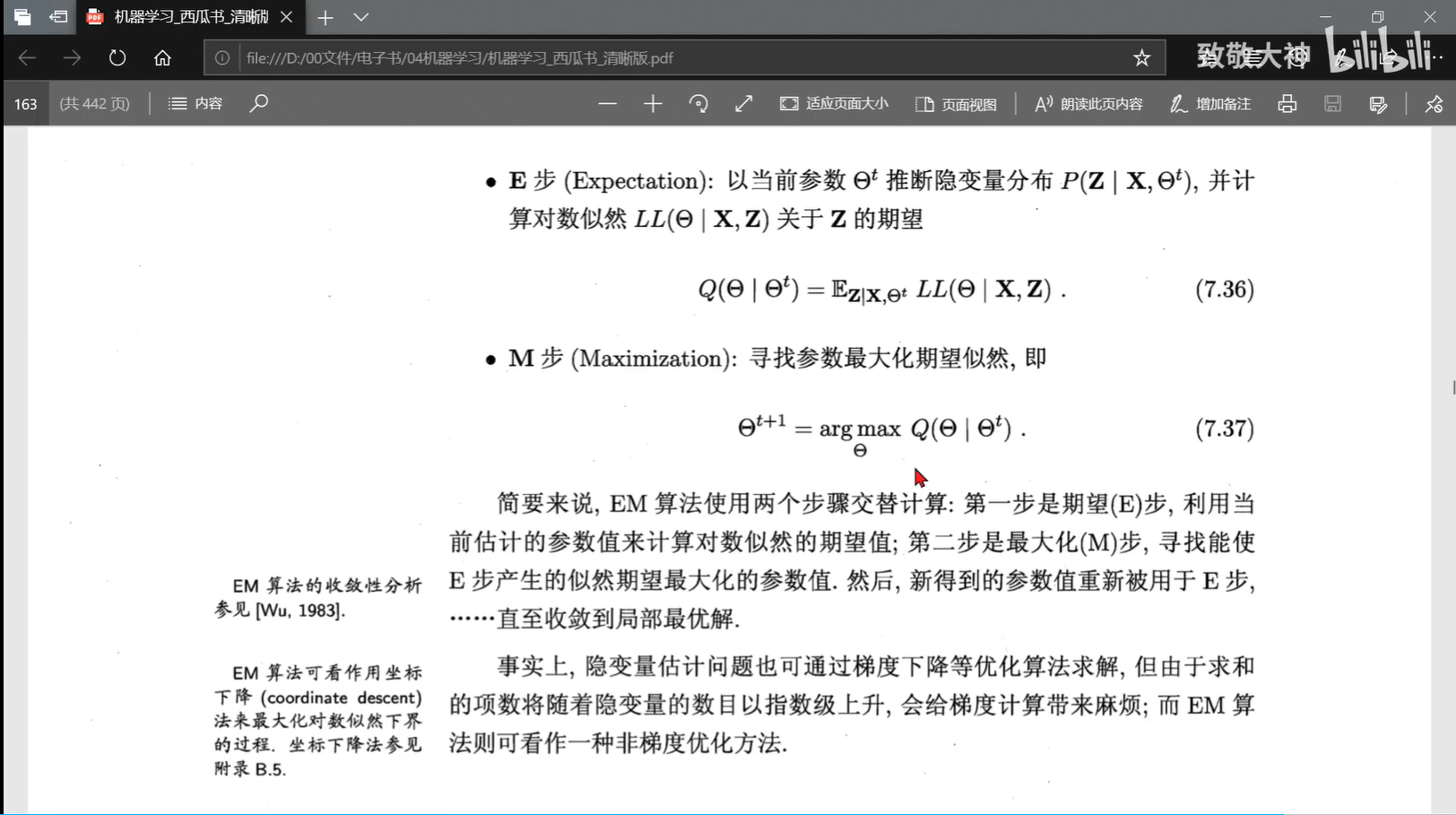

0712 EM算法

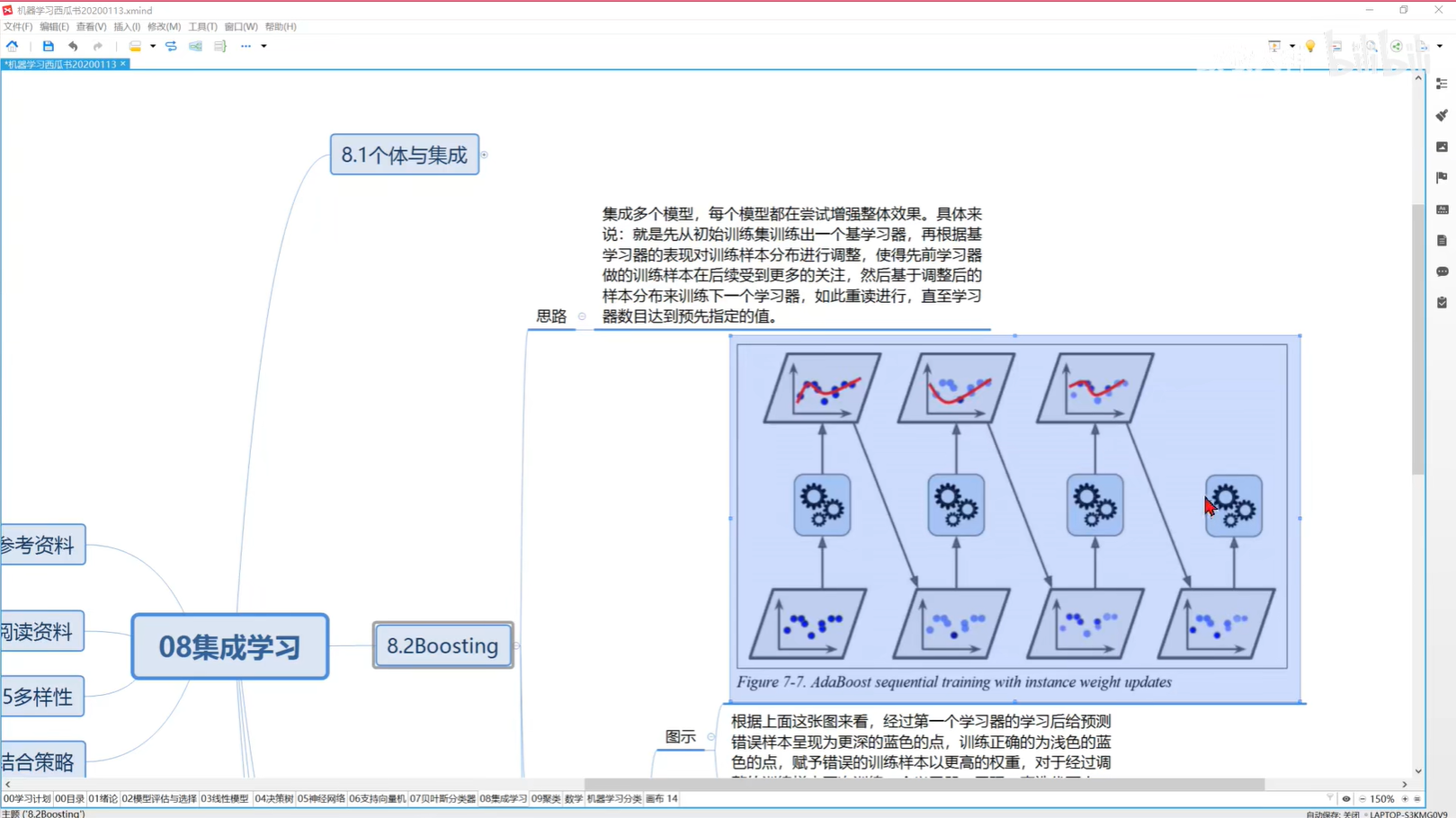

0802 集成学习的威力

0803 AdaBoost原理看个例子包懂

https://zhuanlan.zhihu.com/p/27126737

0804 AdaBoost算法实现

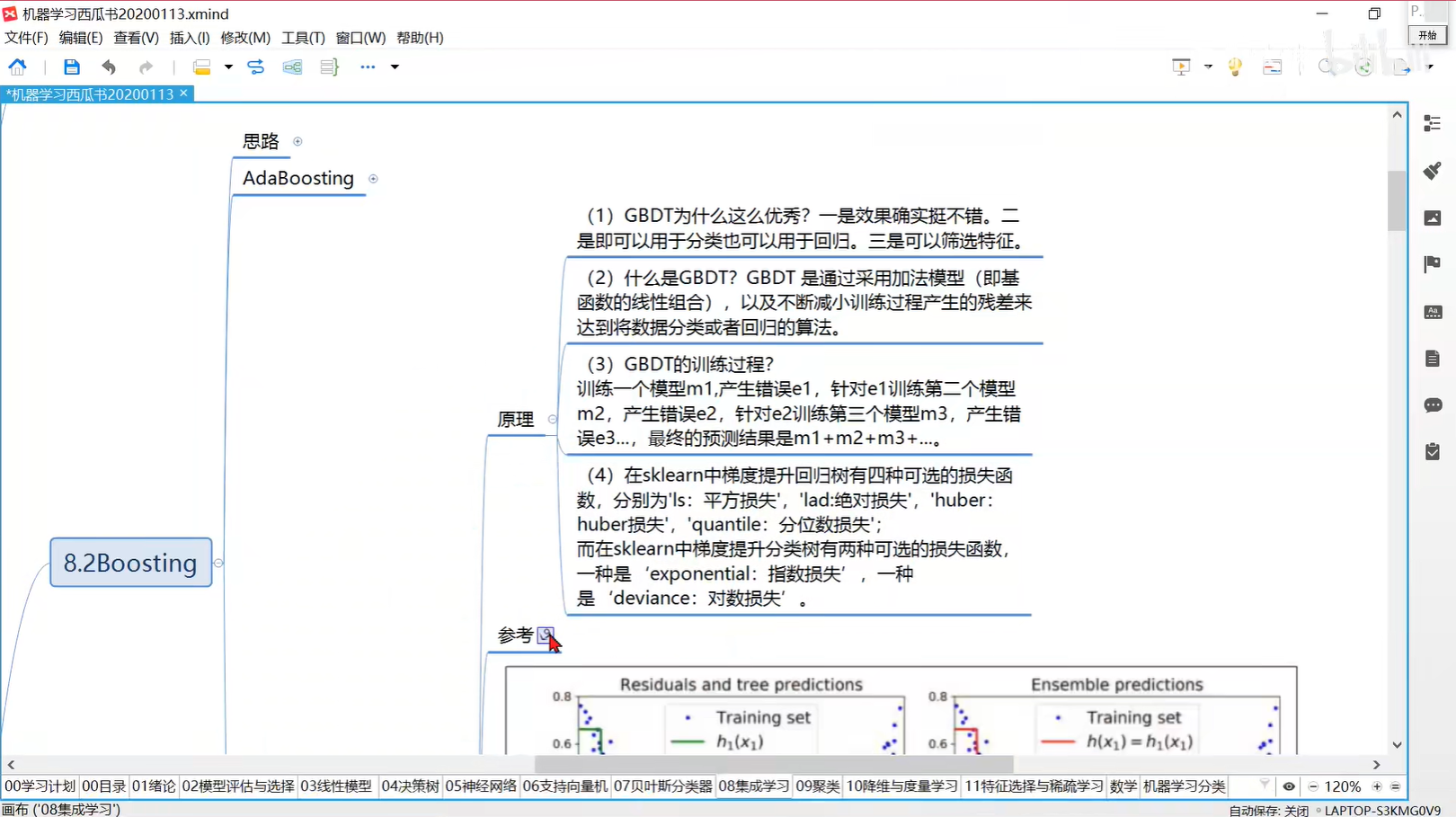

0807 Gradient Boosting简述