35 随机初始化

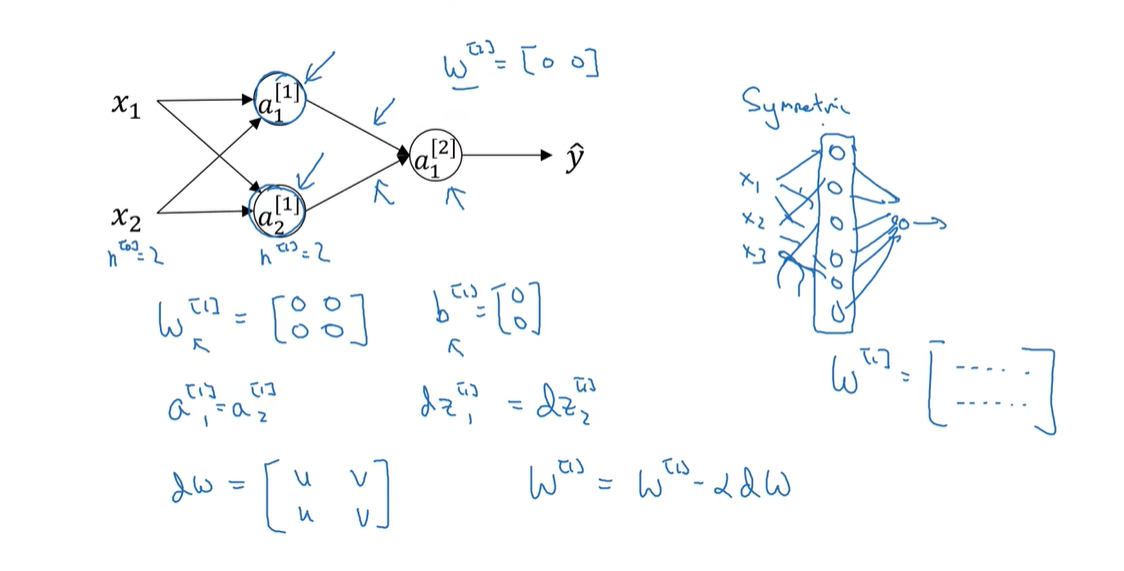

在训练神经网络时,初始化权重的重要性,对于随机初始化的权重,将其全部初始化为零时是不合适的,因为这将导致隐藏单位集散相同的函数,没有区别。相反,初始化为权重为随机值可以解决对称性破缺问题,是隐藏单元计算不同的函数。此外,初始化偏置项和权重的其它注意事项,可以帮助训练更加有效的神经网络。

- 在训练神经网络时,初始化权重的重要性,特别时对于随机初始化的神经网络

- 初始化权重对神经网络训练非常重要

- 初始化为零会导致隐藏单元计算相同的函数

- 初始化参数为随机值可以解决这个问题

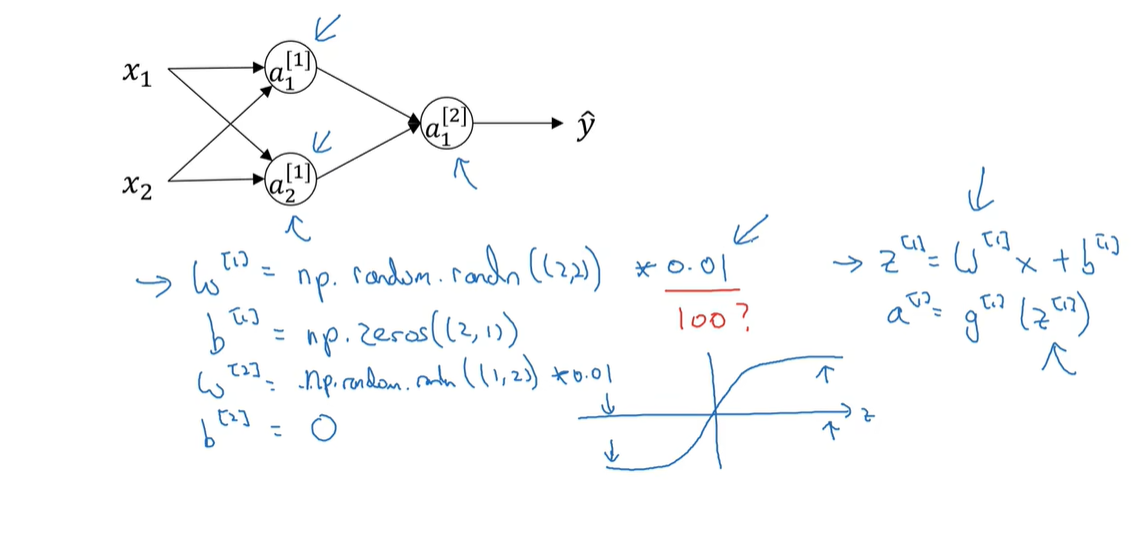

- 如何初始化神经网络的参数,以及为什么通常将权重初始化为较小的随机值

- 初始化权重为小随机值可以避免对称性破缺问题

- 初始化权重过大可能导致激活函数饱和(计算出的值,落在激活函数的平缓部分,则斜率非常小),减缓学习速度

- 初始化常数为0.01(浅层网络一般适用)或其他相对较小的数字(其他深层的网络,则需要仔细选择)

35.1 What happens if you initialize weights to zero

35.2 Random initialization